本期来介绍一个AI翻译漫画的项目:Manga-Translator。

笔者从毕业后就较少看漫,不过偶尔得空还是会看看~

国漫自然没问题,已完结的海外漫画也都有制作组出本地化翻译版本(熟肉)供大家阅读。

但连载中的海外漫画就比较难受了。因为制作组都很忙,一般有固定的发布计划,追的连载最新话他们肯定不会紧赶着翻译出来,所以咱们想看只能抱着硬啃(生肉)。对笔者来说英文还算好,日韩简直地狱~

本篇要介绍的项目,就可以轻松Docker一键部署,帮我们解决这个问题!图片截取取自项目页。

项目介绍

完整项目名:hgmzhn/manga-translator-ui,可于GHUB搜索。如果大家需要了解更多内容,请搜索到项目主页查看,内含各种平台部署流程以及配置使用方式。

本项目可一键翻译漫画图片中的文字,支持日漫、韩漫、美漫,黑白漫和彩漫均可识别。自动检测、翻译、嵌字,支持日语、中文、英语等多种语言。基于 manga-image-translator 核心引擎开发,提供 5 种翻译引擎(包括 OPAI、Gemini、Sakura等及兼容的 AI 翻译),内置可视化编辑器可自由调整文本框和样式。一键安装脚本支持自动配置环境和更新,打包版本开箱即用。

核心功能

- 🔍 智能文本检测:自动识别漫画中的文字区域

- 📝 多语言 OCR:支持日语、中文、英语等多种语言识别

- 🌐 5 种翻译引擎:OPAI、Gemini(普通+高质量)、Sakura

- 🎯 高质量翻译:使用多模态 AI 模型(GPT-4o、Gemini),结合图片上下文进行翻译,准确率更高

- 📚 自动提取术语:AI 自动识别并积累专有名词(人名、地名、组织等),保持长篇翻译的一致性

- 🎨 图像修复:自动擦除原文并智能填充背景

- ✍️ 智能嵌字:自动排版译文,支持多种字体和样式

- 🤖 AI 断句:支持 OPAI、Gemini 翻译器的智能断句功能

- 📦 批量处理:一次处理整个文件夹的图片

准备工作

涉及到AI,因此我们需要任意平台的API Key。模型选择上,建议支持多模态,AI 能「看的到」图片,效果自然会更好。

OPAI以及其兼容接口皆支持,也就是说DS、硅基流动这些都能用。不过我之前写的文章,咱们都用硅基流动白嫖,这次也是OK的。

高质量翻译器的优势:

📸 多模态理解:AI 可以"看到"图片内容,理解上下文

🎯 更准确:结合图片信息,翻译更符合场景

📝 批量处理:一次发送多张图片,AI 理解整体剧情

🔧 自定义提示词:支持自定义翻译风格和术语表

部署流程

翻译效果好坏取决于你用的模型!!!!!!!

为保证最终效果,建议整章节导入,方便AI理解~

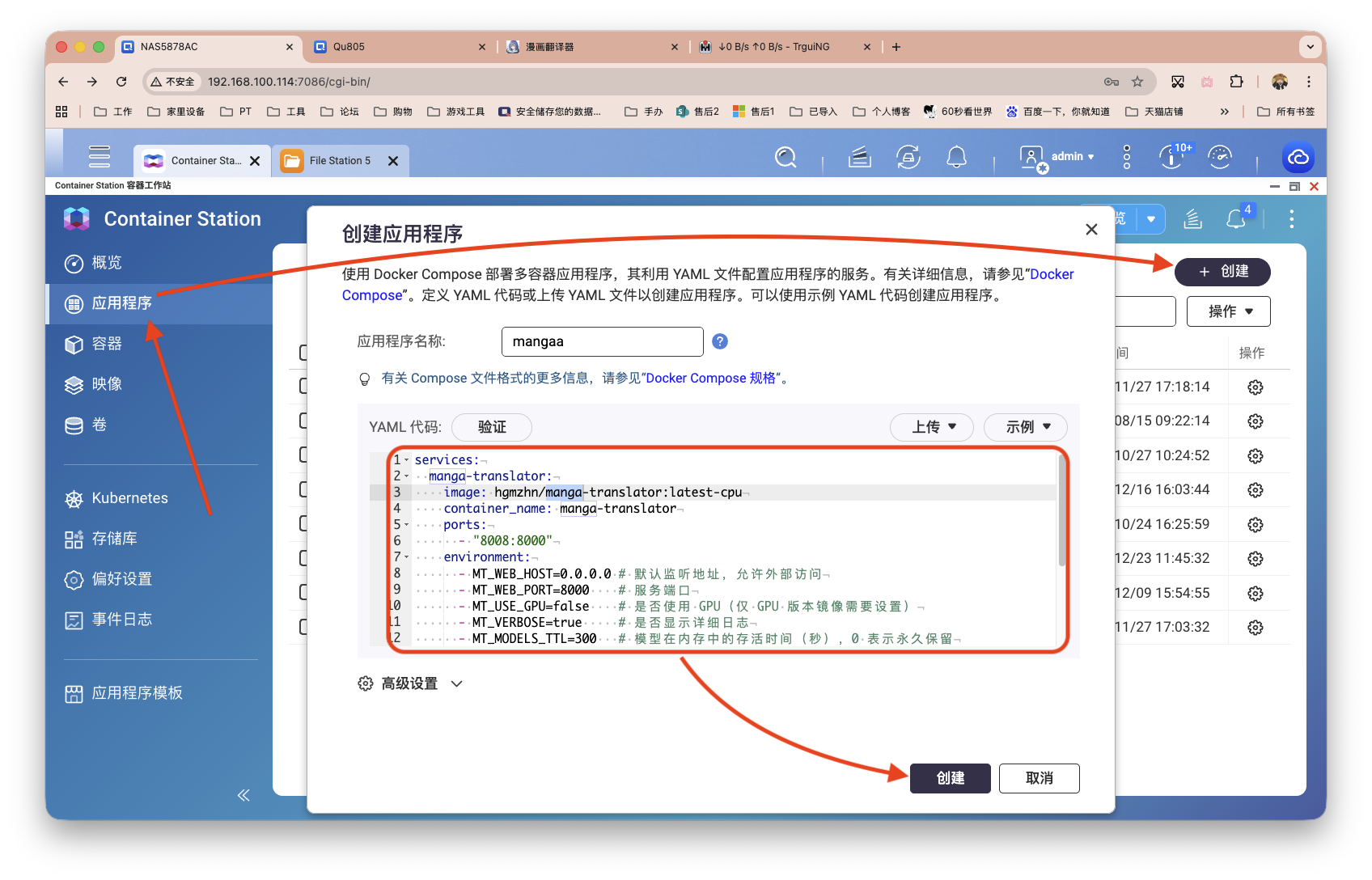

部署以威联通为平台进行演示,通过Docker Compose的方式进行。

作者虽然表明Docker部署是试验性,但我用起来感觉还好。原本的部署代码:

# Windows CMD / PowerShell

docker run -d --name manga-translator -p 8000:8000 hgmzhn/manga-translator:latest-cpu

# Linux / macOS

docker run -d --name manga-translator -p 8000:8000 hgmzhn/manga-translator:latest-cpu

# CPU 版本:hgmzhn/manga-translator:latest-cpu

# GPU 版本:hgmzhn/manga-translator:latest-gpu

# 性能越强,体验越好

我个人整理的代码:

services:

manga-translator:

image: hgmzhn/manga-translator:latest-cpu

container_name: manga-translator

ports:

- "8008:8000"

environment:

- MT_WEB_HOST=0.0.0.0 # 默认监听地址,允许外部访问

- MT_WEB_PORT=8000 # 服务端口

- MT_USE_GPU=false # 是否使用 GPU(仅 GPU 版本镜像需要设置)

- MT_VERBOSE=true # 是否显示详细日志

- MT_MODELS_TTL=300 # 模型在内存中的存活时间(秒),0 表示永久保留

- MT_RETRY_ATTEMPTS=None # 翻译失败重试次数,-1 表示无限重试

- MANGA_TRANSLATOR_ADMIN_PASSWORD=your_admin_password # 管理员密码

volumes:

- /share/Container/manga-translator/models:/app/models

- /share/Container/manga-translator/result:/app/result

- /share/Container/manga-translator/logs:/app/logs

- /share/Container/manga-translator/work:/app/manga_translator_work

restart: always

有些是可删除的,不删也没啥影响。文件映射,涉及到了日志、模型等的关键目录持久化,建议做。

没问题后,打开威联通的Container Station创建新的应用程序。

使用演示

功能实在是多,就展示下如何基础的配置并启用,再就是成果(放最后统一)展示。

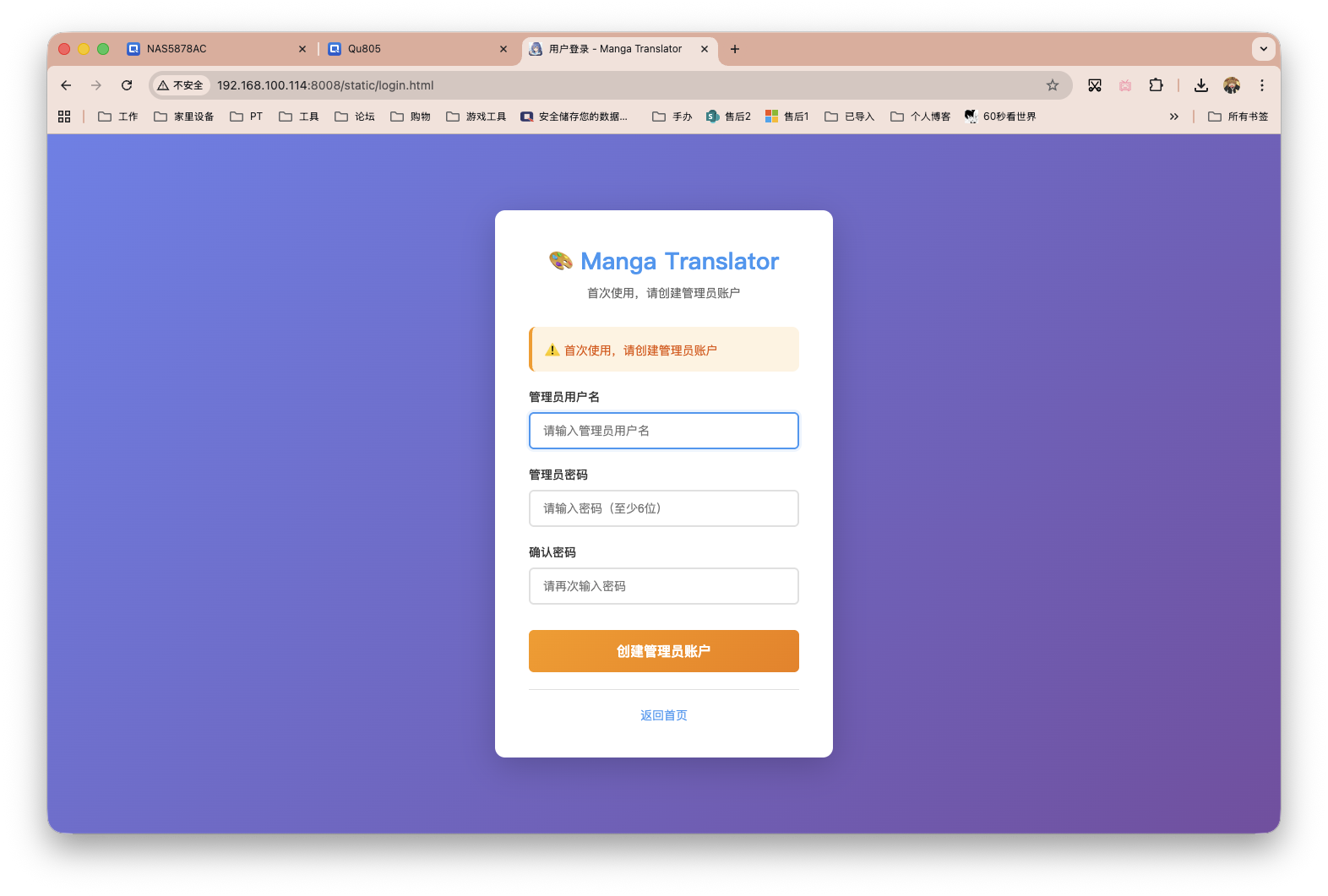

部署完毕后,浏览器输入NAS_IP:8008即可访问服务。初次使用,注册个管理员账户。

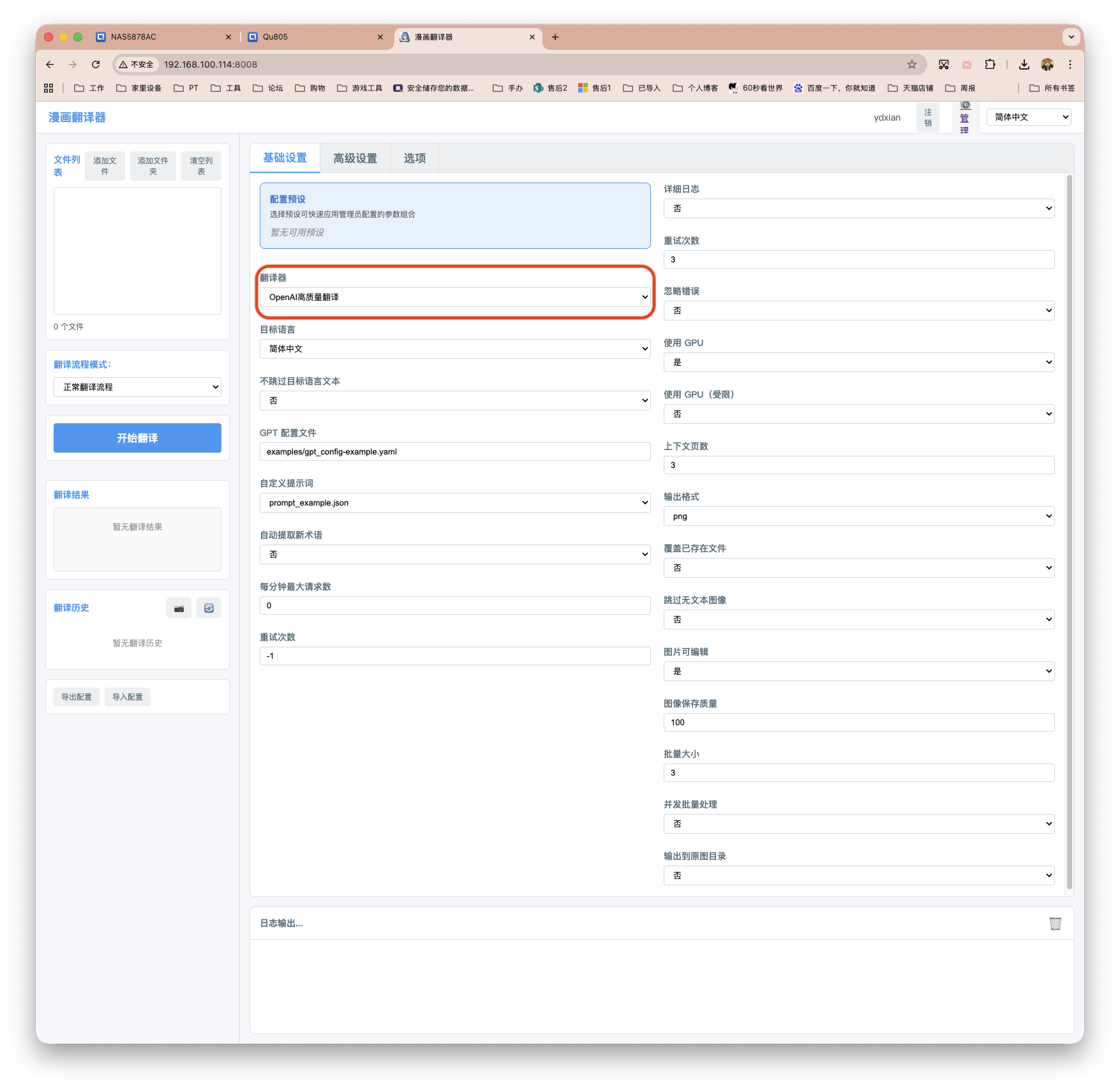

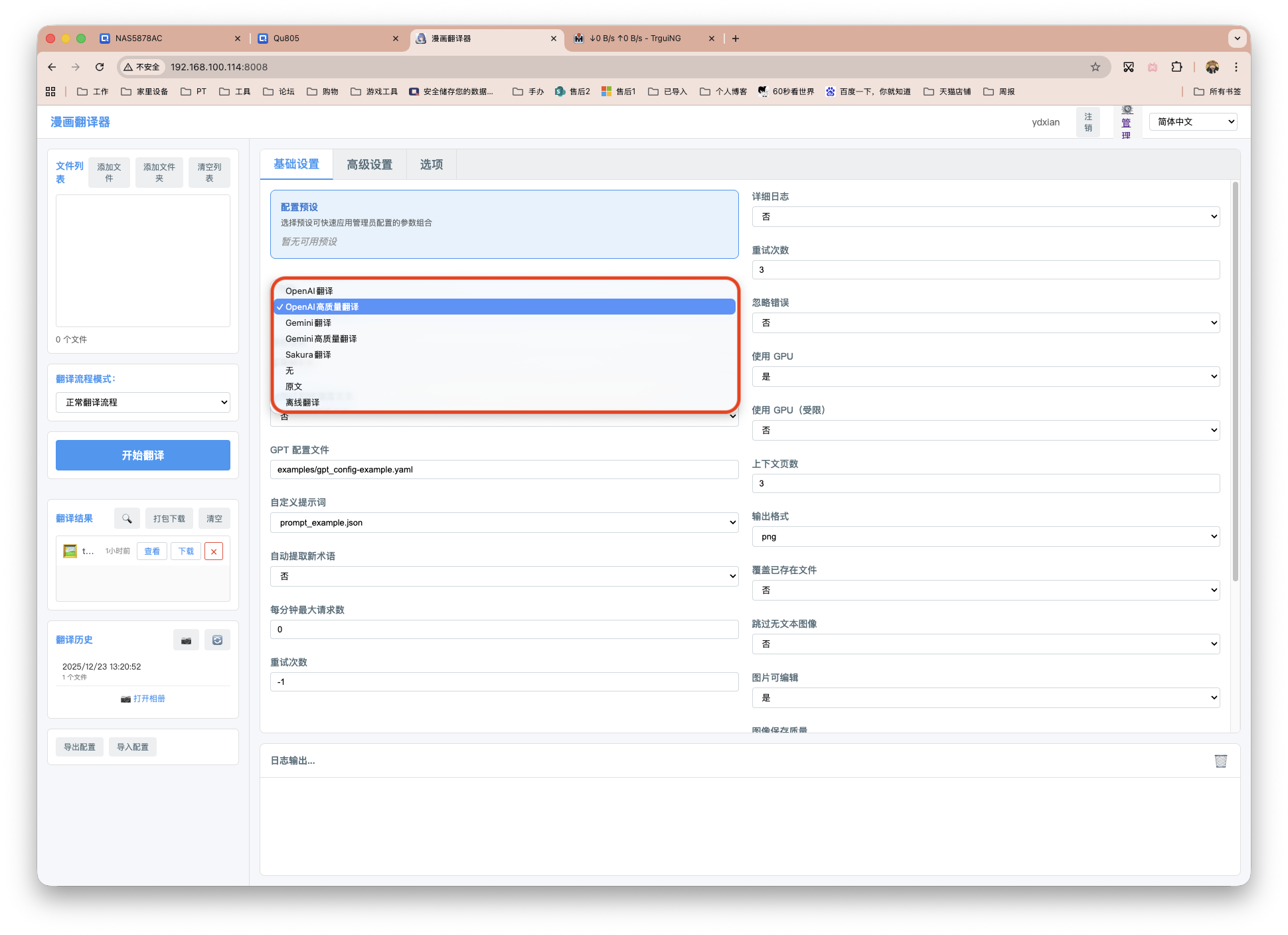

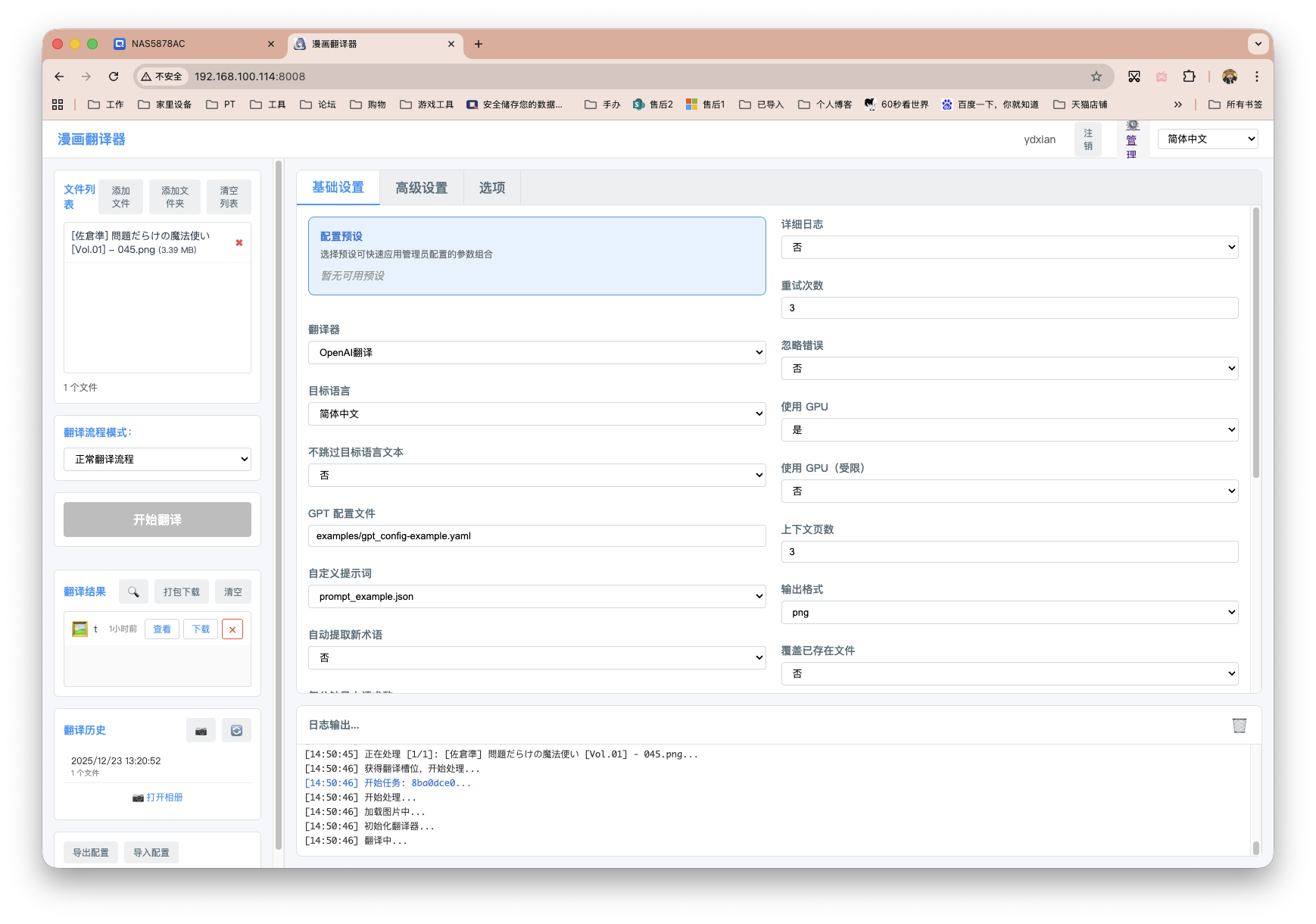

登录进来,如下图所示。比较重要的就是红框的这个API接口选择。

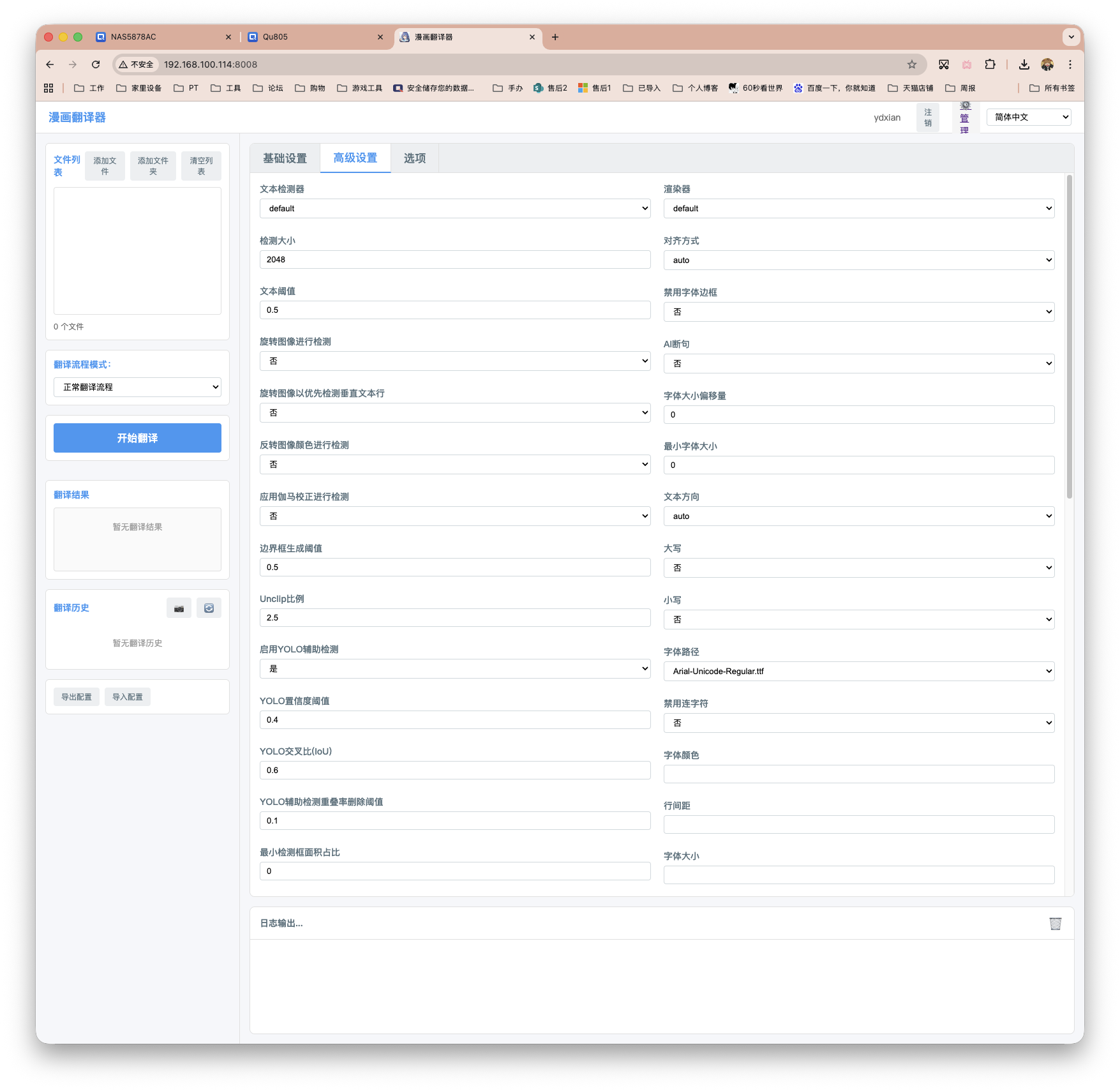

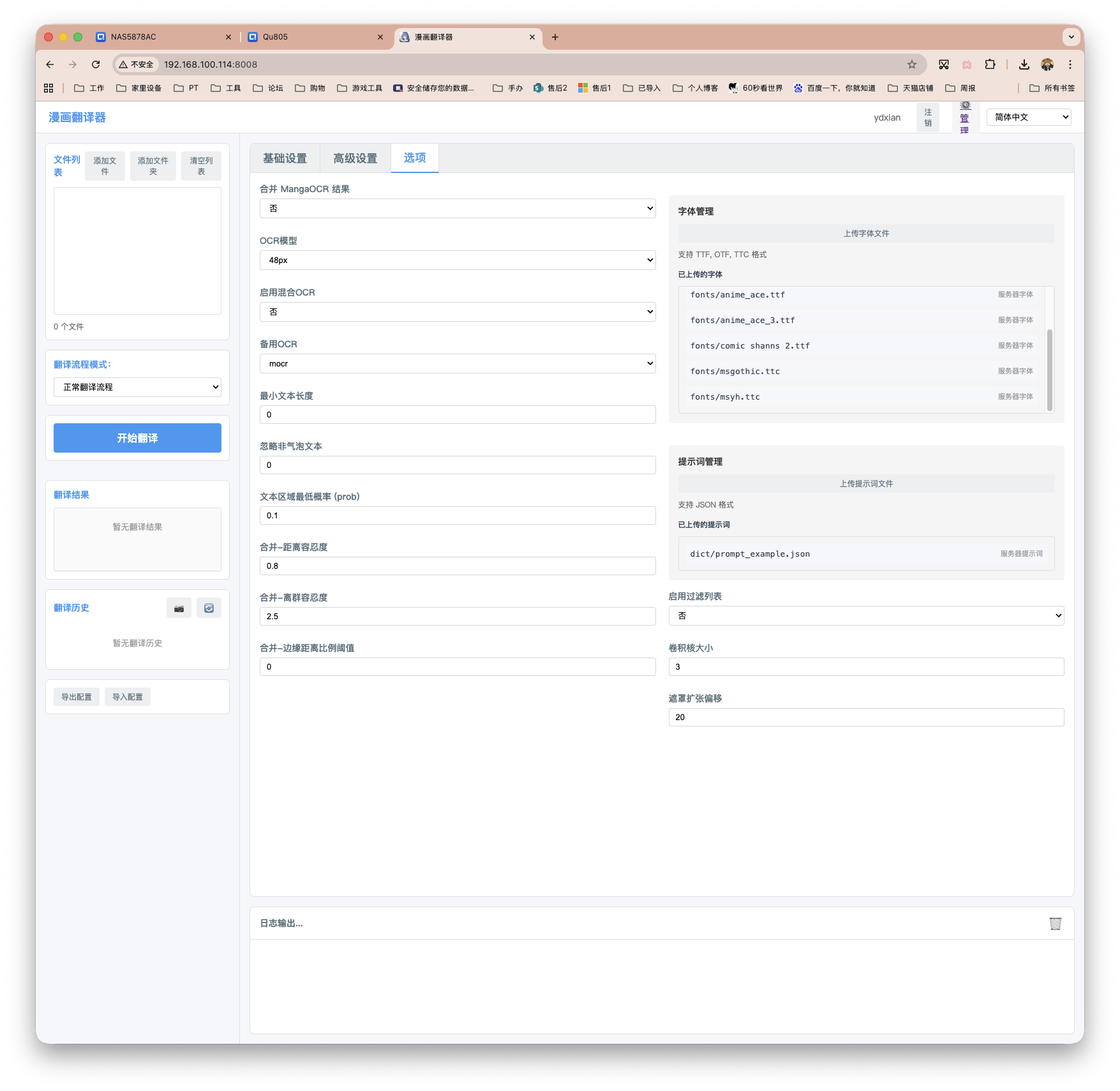

高级设置和选项。能调整的地方也是很多,比如OCR模型,超分模型,排版,渲染,字体等等。我看作者说MangaJaNai这个超分模型很惊艳,现在默认的配置也是用的这个。

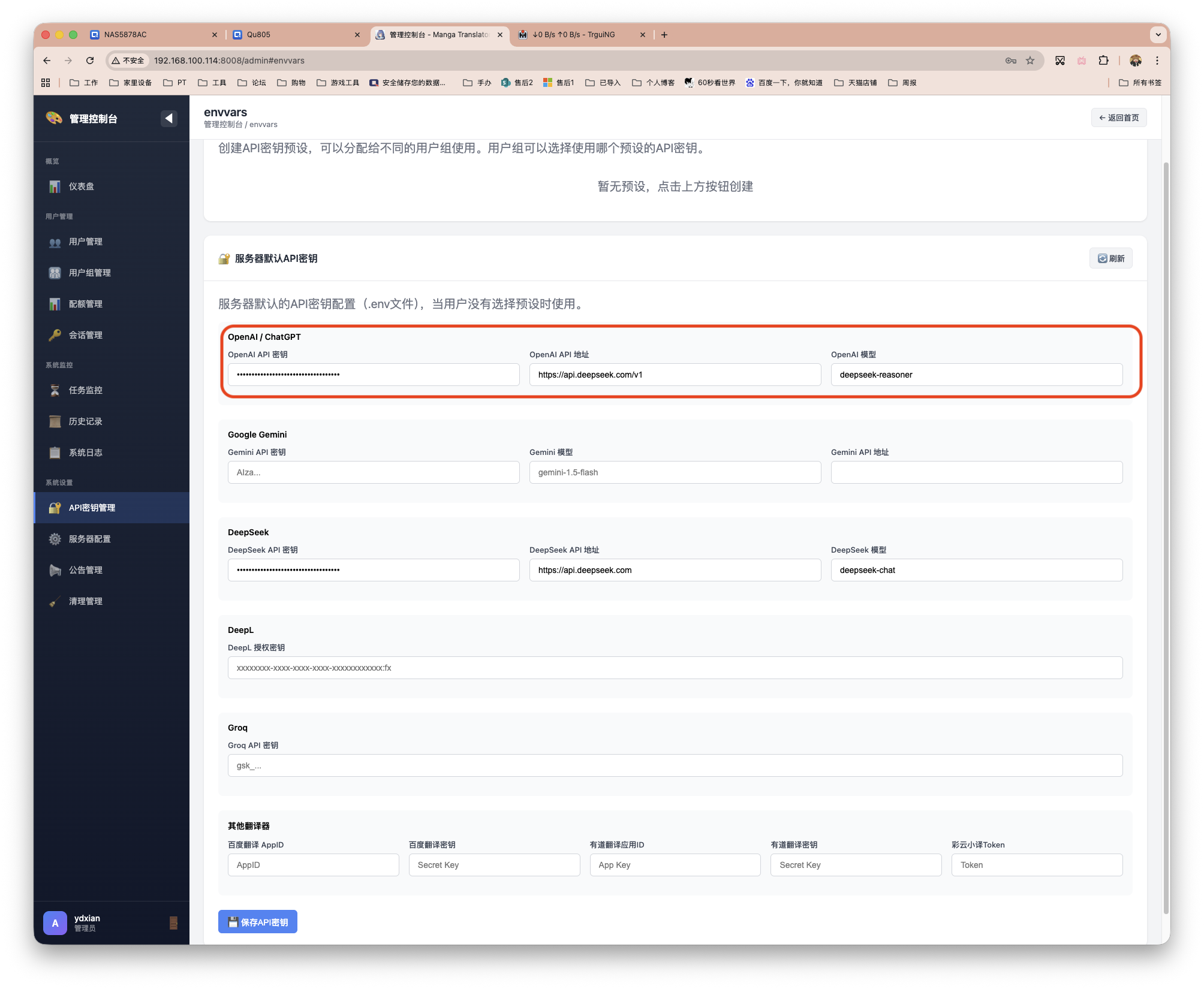

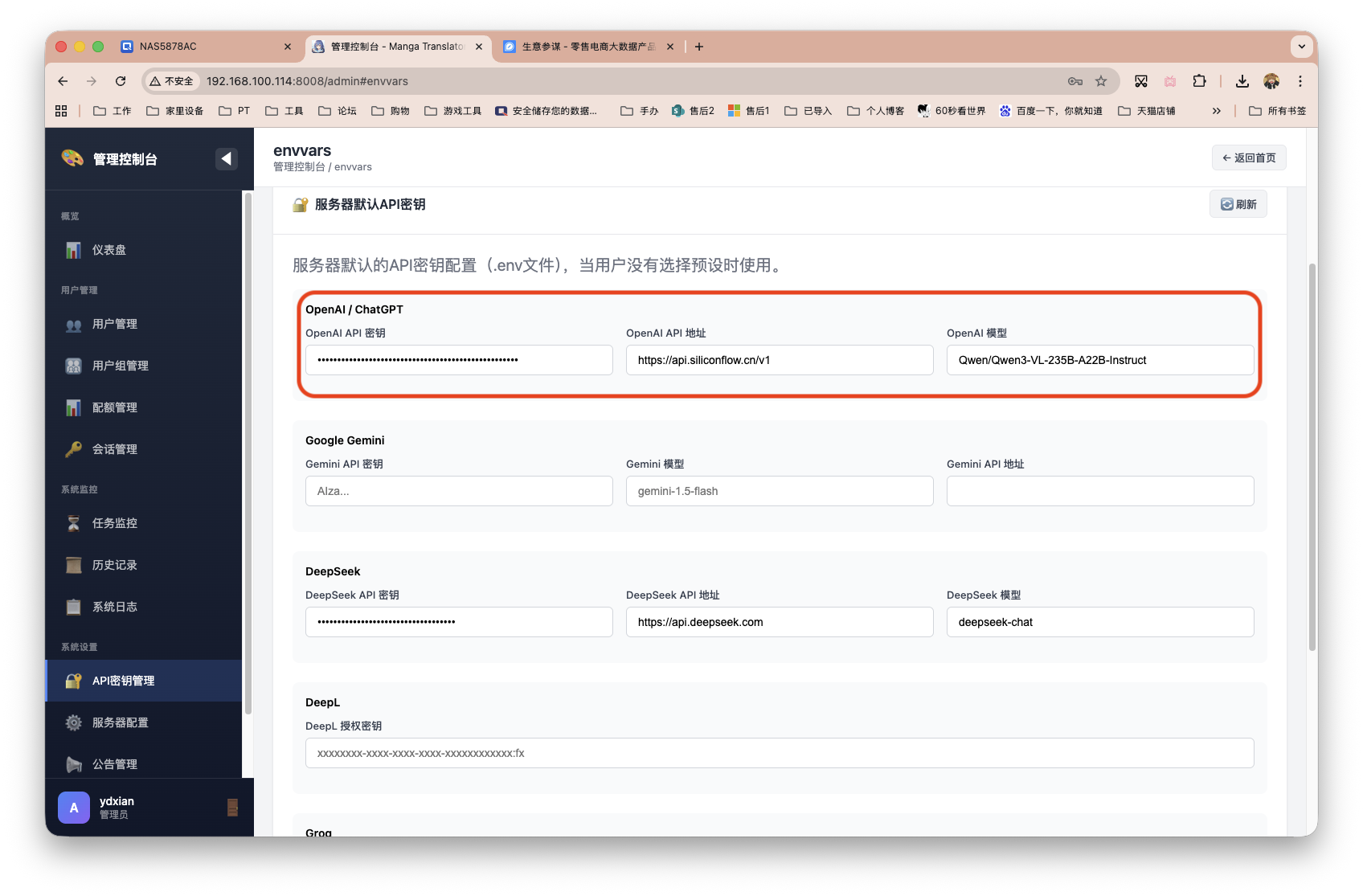

接着开始配置API。点击上图右上角的「管理」进入控制台,左侧栏点击「API密钥管理」。填写相关内容。

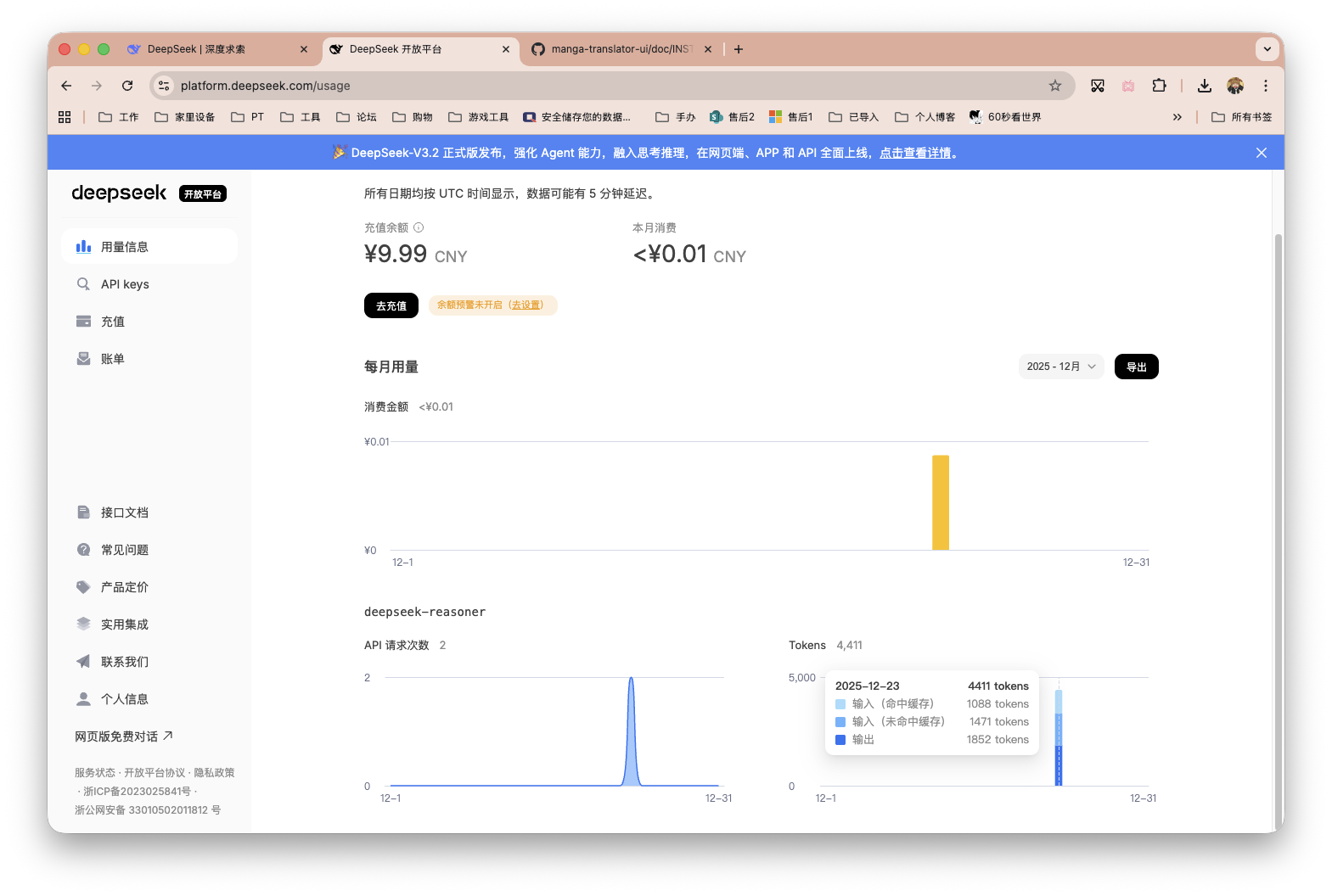

我这里先尝试了DeepSeek。注意URL填写。完事了别忘记保存,再点击右上角「返回首页」回到「基础设置」。

DeepSeek模型不支持多模态,因此我们翻译器要选择普通的第一项。

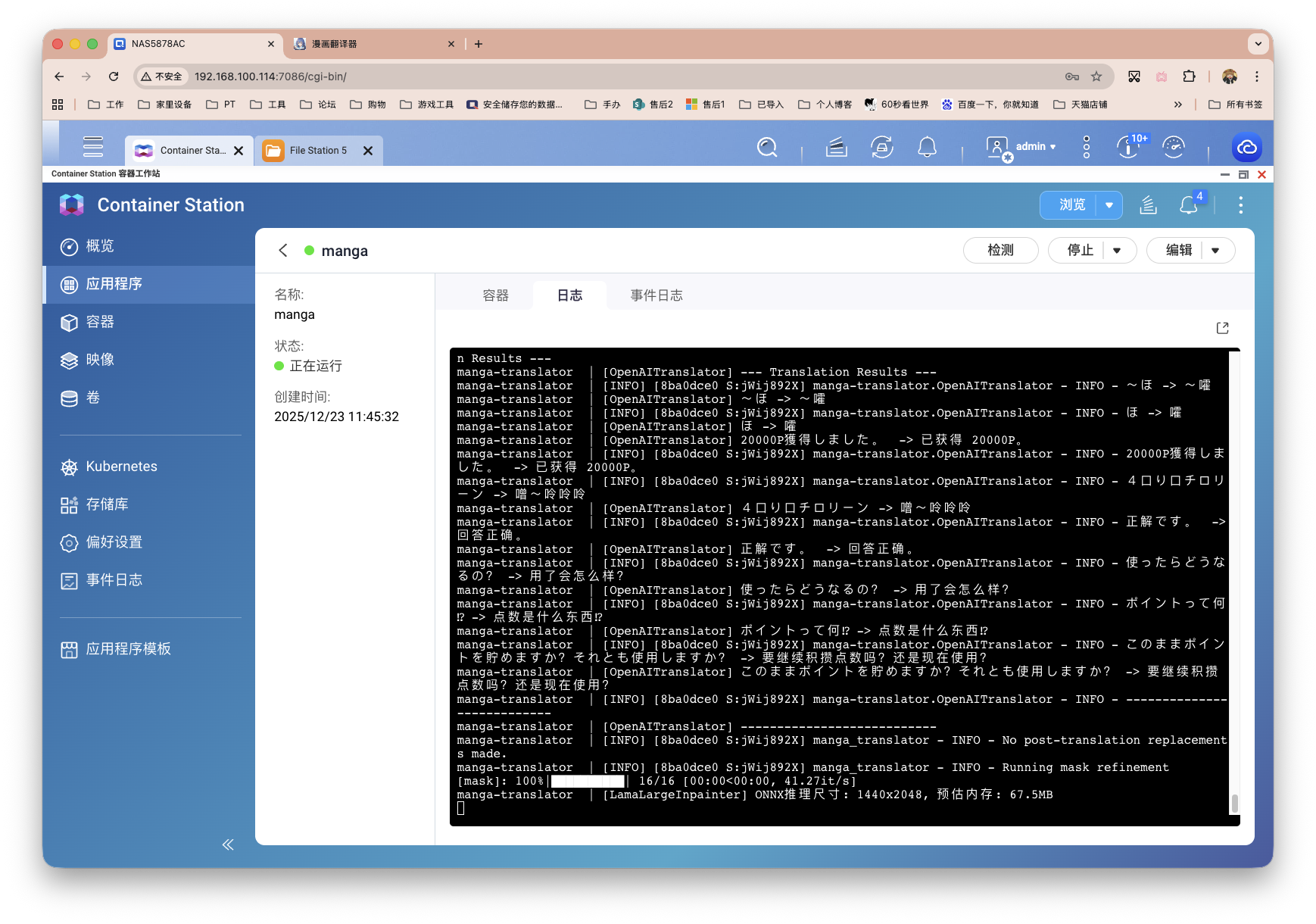

上传漫画,点击开始翻译等待结束即可。这里我挑了佐仓老师的新作《問題だらけの魔法使い》其中一页测试,年初就有网友觉得这本漫的翻译难度可能会有点高。

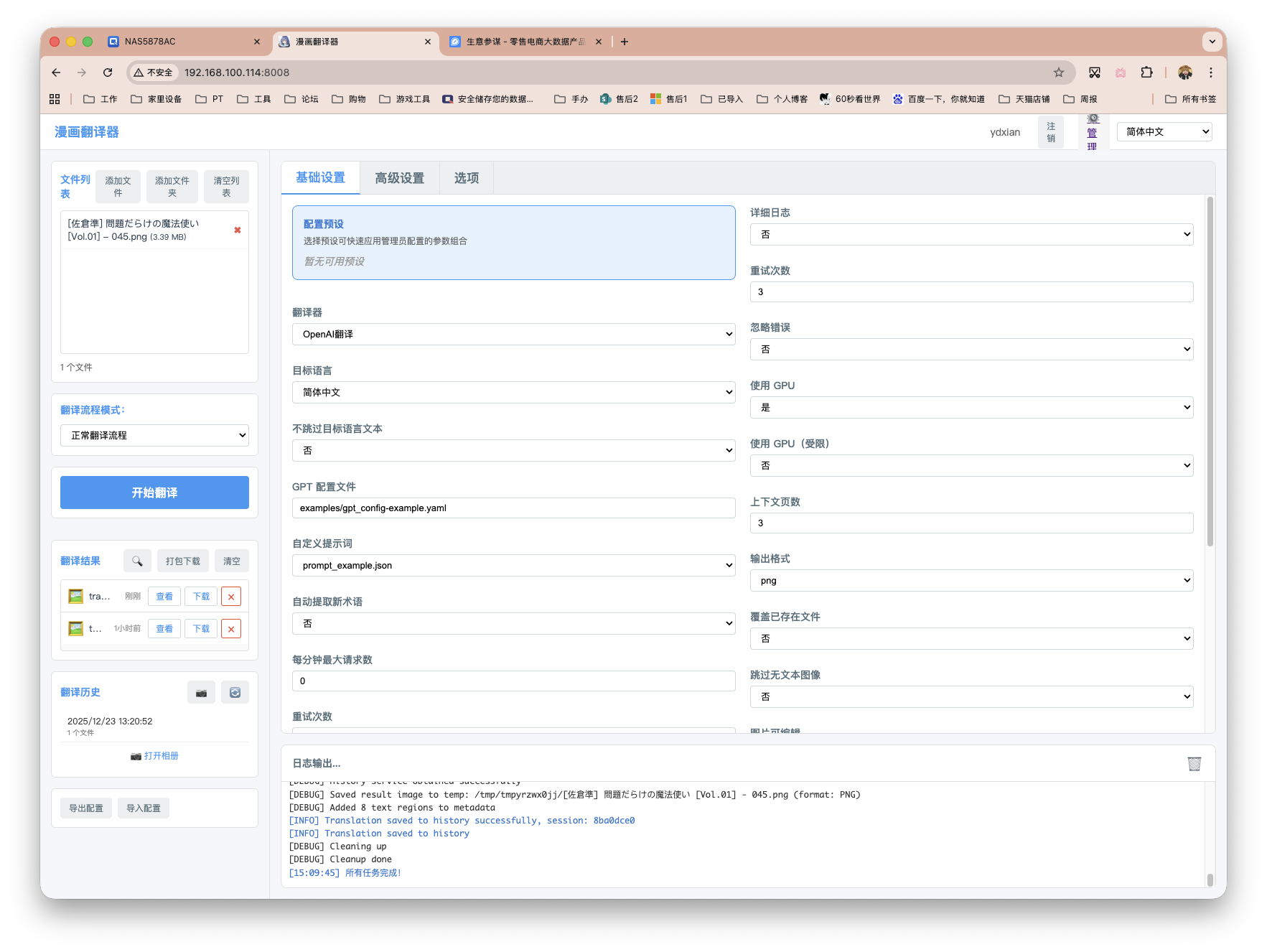

跑完了,左侧可以预览、下载成品。

两张漫画的大概消耗。

接着我再用硅基流动的免费余额跑跑看,免费余额虽然有用量级别限制,但是可用高阶支持多模态的模型。因此这里我也替换成了高质量翻译。

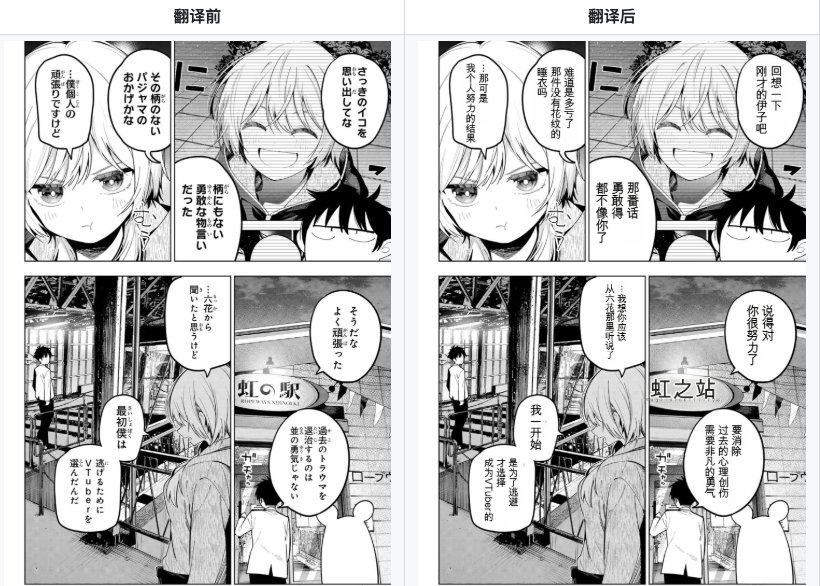

成品展示

从左至右,分别为,生肉——硅基流动——DeepSeek。文本位置这个可以调整,重要的是翻译结果。有付费高阶API的朋友部署测试后,也欢迎留言分享体验。

原文生肉,以及硅基流动的高质量翻译。

最后

我觉得效果还蛮不错,正如作者所说,条漫的支持已经非常好了。

不过部署到一般性能NAS上,跑起来还是挺慢的,建议尽量部署在今年的新品或者自己DIY配置较高的设备上。当然具备NV独显是最好的!

感谢观看,本文完。

评论区