碎碎念

最近DeepSeek真的太火,文章视频全随便一刷全都是。我平时基本都在用OPAI,听说DeepSeek后,也穿插着使用到现在。

目前DeepSeek在线是V3版本,确实很有意思,他具备最重要的思考能力,给出的回答真的让人感觉他确实在思考,有时候甚至会被逗乐,不知道大家在使用时是否会有类似体验。

关于大模型的本地部署案例,不仅仅DeepSeek,其他大部分也都是依靠本地Ollama,然后再部署个前端UI接入来进行使用。

本地模型的部署十分吃配置,一般来说都要配置独立显卡,经过实际体验测试14B的命中率低到我个人无法忍受的程度,但折中来说32B(需独显16G显存以上)就非常不错了。我们以DeepSeek为例来看看所需配置。

DeepSeek-R1-Distill-Qwen-1.5B(约 1 GB GTX 1050 及以上)

DeepSeek-R1-Distill-Qwen-7B(约 4 GB RTX 3060 及以上)

DeepSeek-R1-Distill-Llama-8B(4.5 GB RTX 3070 及以上)

DeepSeek-R1-Distill-Qwen-14B(约 8 GB RTX 4070 及以上)

DeepSeek-R1-Distill-Qwen-32B(约 18 GB RTX 4080 及以上)

DeepSeek-R1-Distill-Llama-70B(约 40 GB RTX 4090 或 A100)

所以想玩的朋友要么拿起手头的显卡,要么部署前端调用API。在我个人看来,NAS作为本地容器部署就是个乐子(除非能插独显!),部署一个好用的前端才是市面上正经消费级NAS该干的活儿。虽说我的TS-673A插了一块1050Ti,但这种性能本地部署意义的确不是太大,如果大家感兴趣,后面也会出一期。

本篇文章会分享在威联通NAS上,通过Docker部署目前来说应该最牛的开源AI聊天框架:Lobe Chat数据库版的流程,API选择硅基流动提供的DeepSeek。

Lobe Chat 是一个基于 开源大模型 的 AI 对话平台,支持自定义 AI 角色、插件扩展,并提供可视化的工作流设计。它适用于私人助手、企业客服、AI 研究 等场景,支持 本地部署,也可集成 (OPAI / Claude 3 / Gemini / Ollama / Qwen / DeepSeek)等大模型,提供高效、安全的 AI 交互体验。

前期准备

Lobe Chat 支持的部署场景:

本地模式(默认):仅能在本地访问,不支持局域网 / 公网访问,适用于初次体验;

端口模式:支持局域网 / 公网的 http 访问,适用于无域名或内部办公场景使用;

域名模式:支持局域网 / 公网在使用反向代理下的 http/https 访问,适用于个人或团队日常使用;

这里选择第三种,域名模式部署通过HTTPS访问。

✅ 注册硅基流动账户

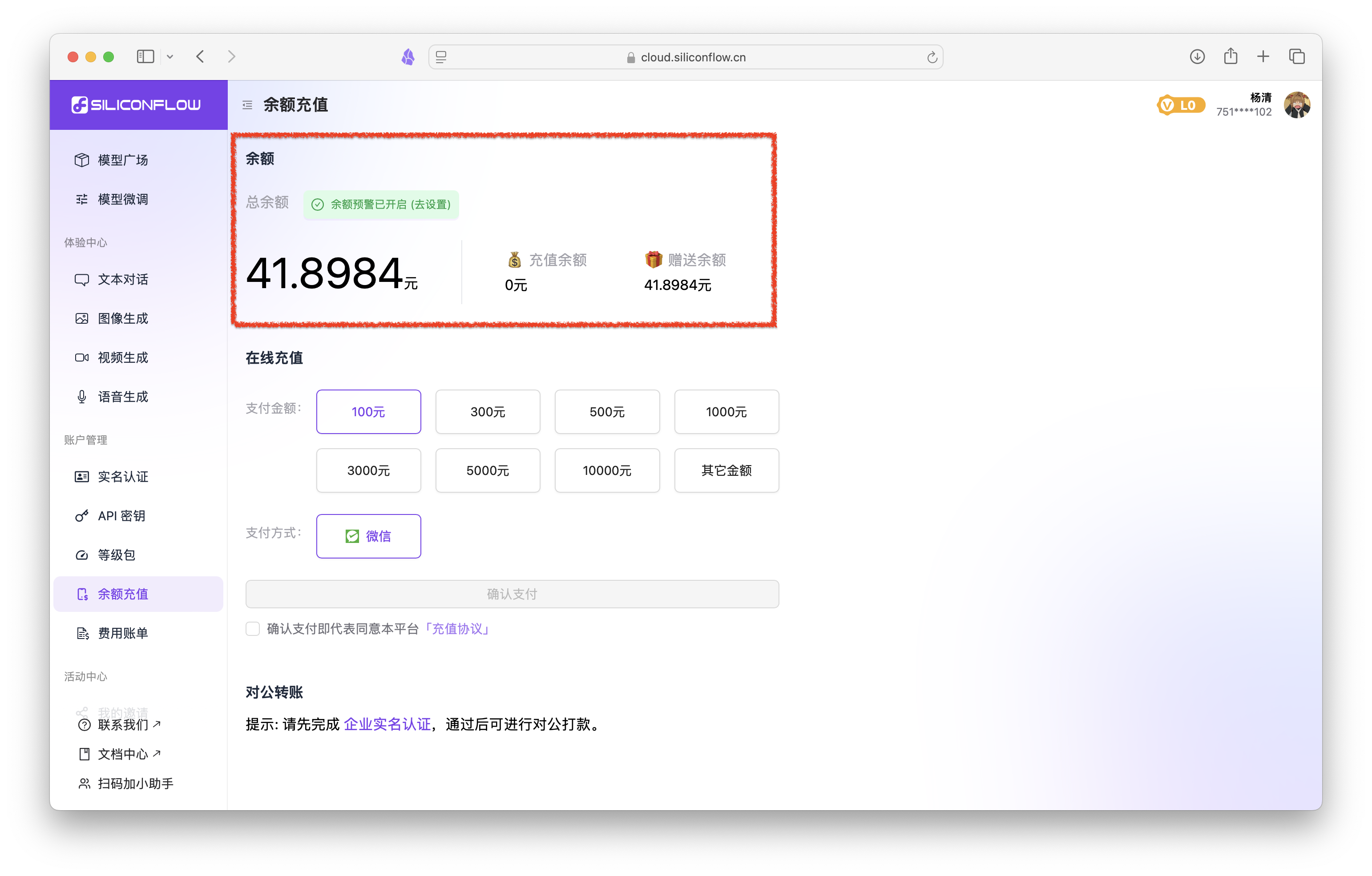

点我跳转注册。目前新账户注册会送14块的余额,能体验蛮久的。但是要注意白P的现在的确很多,大家共用一个服务,响应时间可能会慢。

如果大家已经本地部署了大模型,或者有其他服务商的API则无需注册。

注册完毕后登陆,可以看到余额已经到账。

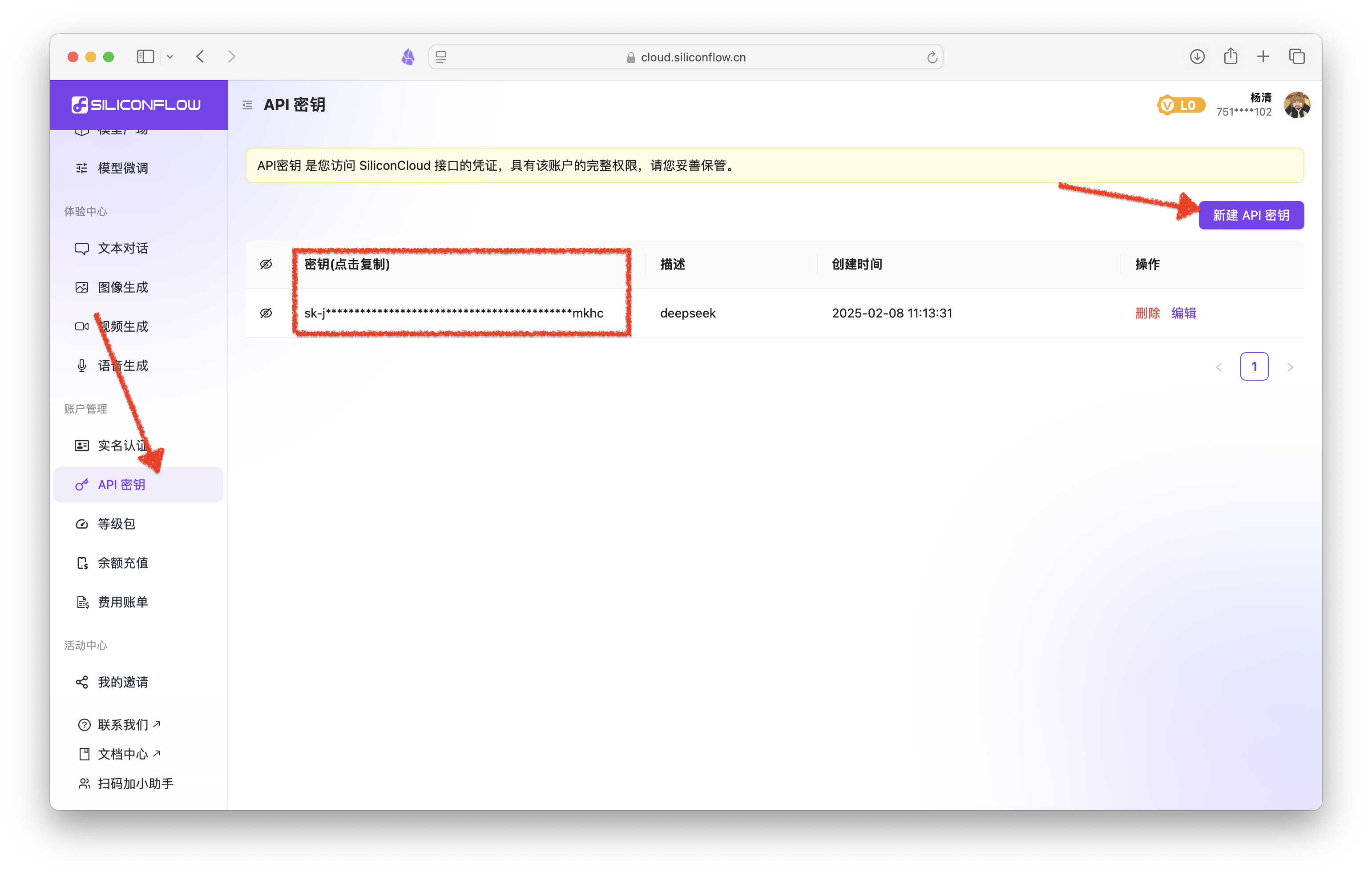

左侧栏点击API密钥,然后新建API密钥。密钥可以直接点击复制,创建个txt文档复制下来放一边备用。如下图所示。

✅ 反向代理

这里建议使用Lucky进行反代。具体操作请查看往期Lukcy使用教程。

端口占用:确保 3210、8000、9000、9001 端口可用。如果你的端口已经被占用,可以改成其他端口,这里我们就先选择未占用端口,下文部署时会提示修改。

参照下图进行反代。

这一步搞定后,把这几个域名COPY下来放进上面的密钥文件一起备用。

开始部署

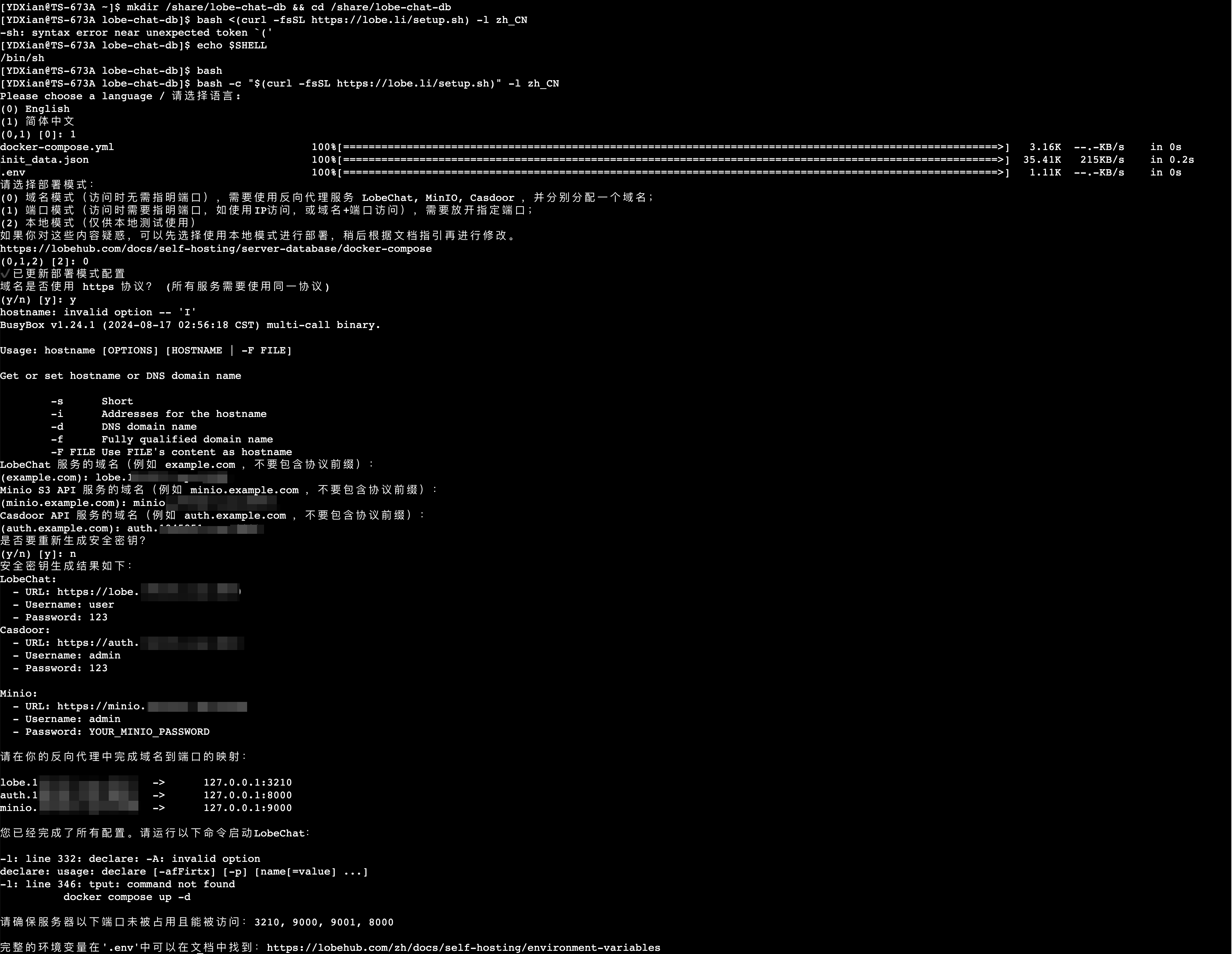

此阶段全程通过SSH连接NAS后台解决。

以往我们都是通过Docker Compose在Container Station中自定义部署,但这次考量之后还是通过官方脚本部署更为便捷,可以省去配置数据库和对象存储等步骤。

下面就一起来操作,最后会截图展示操作流程。

# SSH连接NAS,非22默认端口自行查找命令

ssh admin@192.168.200.132

# 创建目录,存放配置文件和数据库文件

mkdir /share/Container/lobe-chat-db && cd /share/Container/lobe-chat-db

# 手动切换到 bash,因为默认 Shell 仍然是 sh

echo $SHELL

bash

# 执行部署脚本

bash <(curl -fsSL https://lobe.li/setup.sh) -l zh_CN

# 输入1并回车,选择中文模式

# 等待下载三个文件

# 接着输入0并回车,选择域名模式

# 输入y并回车,选择https协议

# 依次输入前面反代好的二级域名,一步一回车。包含端口的也要填写端口,参考图片

# 输入n,不重新生成密码,因为脚本缺失,但后面可以进web改,这个无所谓

# 如果你的端口被占用,务必执行这一步提前修改!环境变量文件中3210、8000、9000、9001四个端口,docker compose.yaml文件中的5432数据库端口。

# 另外环境变量文件中的域名在脚本自动修改后可能出现乱码,也注意一下

vim .env

vim docker-compose.yml

# 英文输入状态下。i进入编辑模式修改,esc退出。同时按SHIFT和冒号,输入wq保存退出。

# 启动Docker

docker compose up -d

等待部署,测试过好几台威联通NAS,不出意外大家应该都会部署成功。

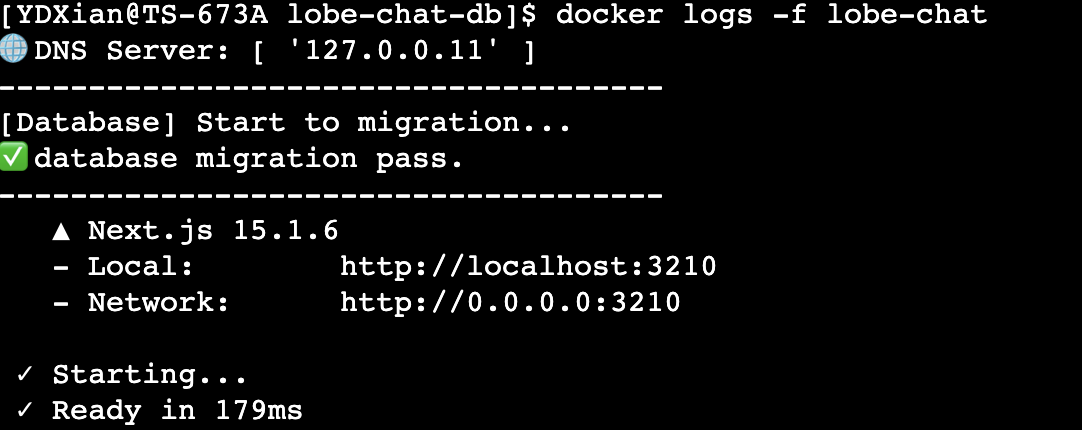

# 查看日志,输出如图片所示则意味着成功

docker logs -f lobe-chat

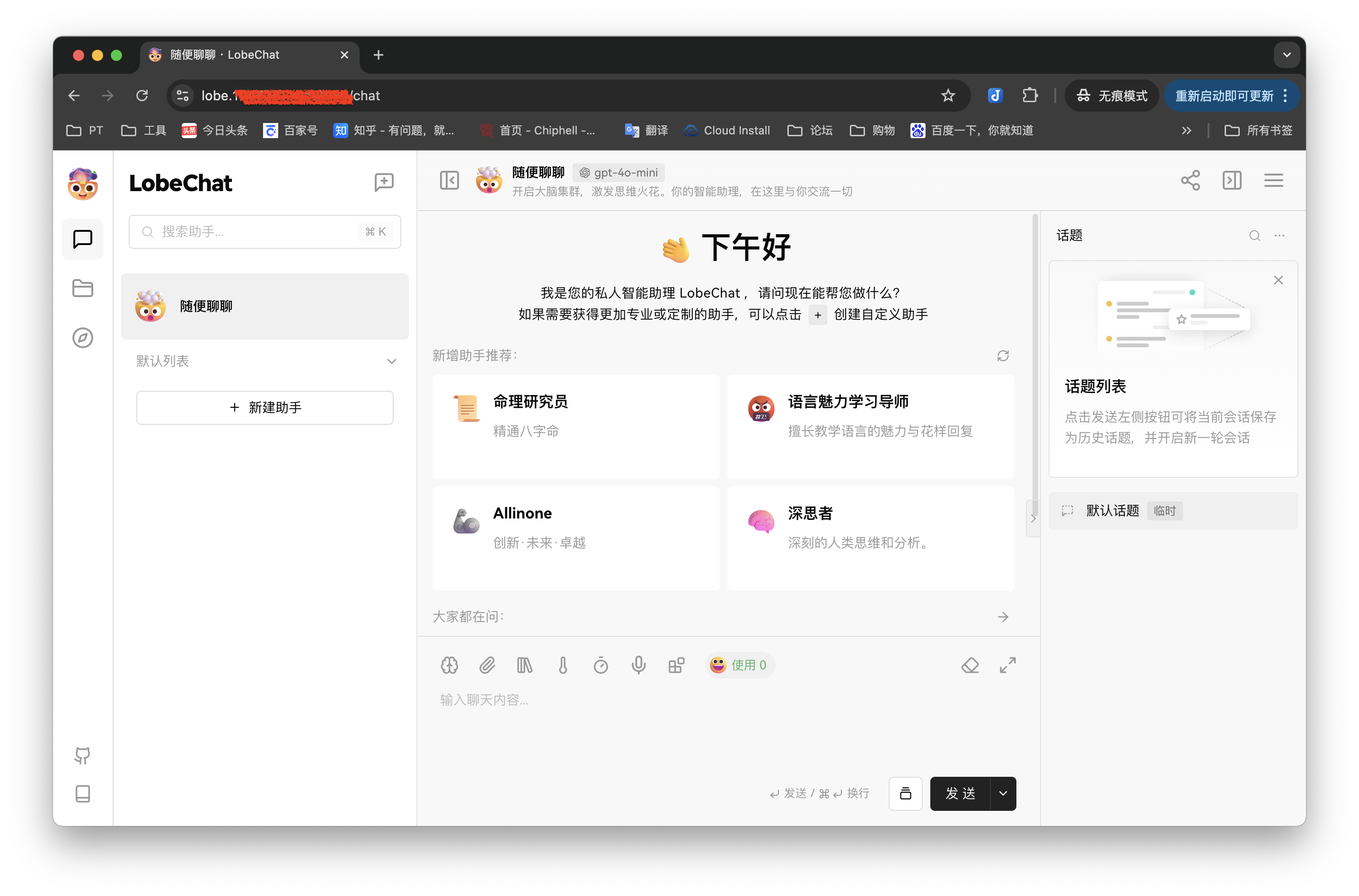

访问并配置

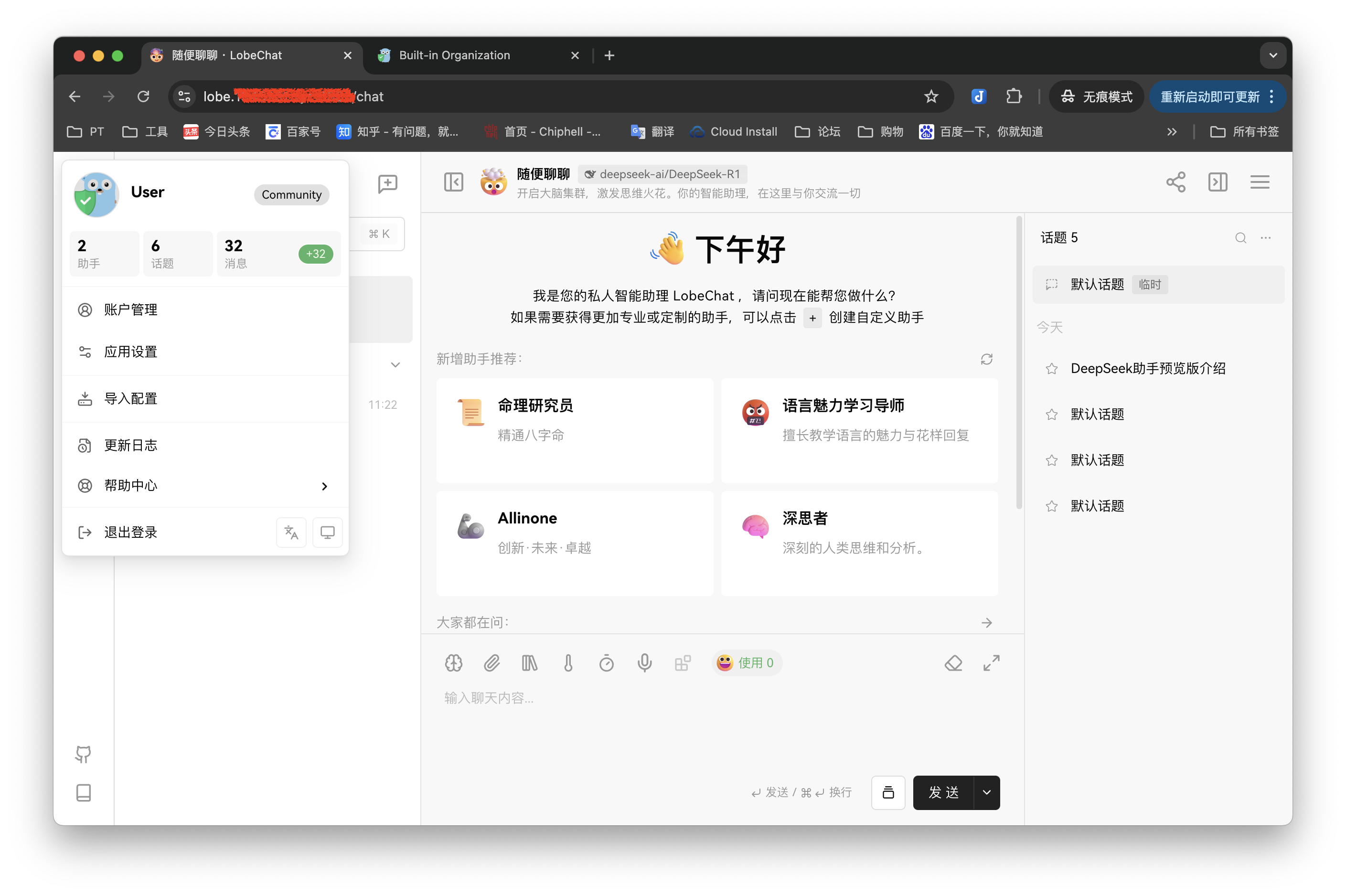

此时web输入lobe前缀的域名,即可访问lobe chat界面。但是使用功能则需要登陆才行,账户密码:user/123。这里先别急着登陆。

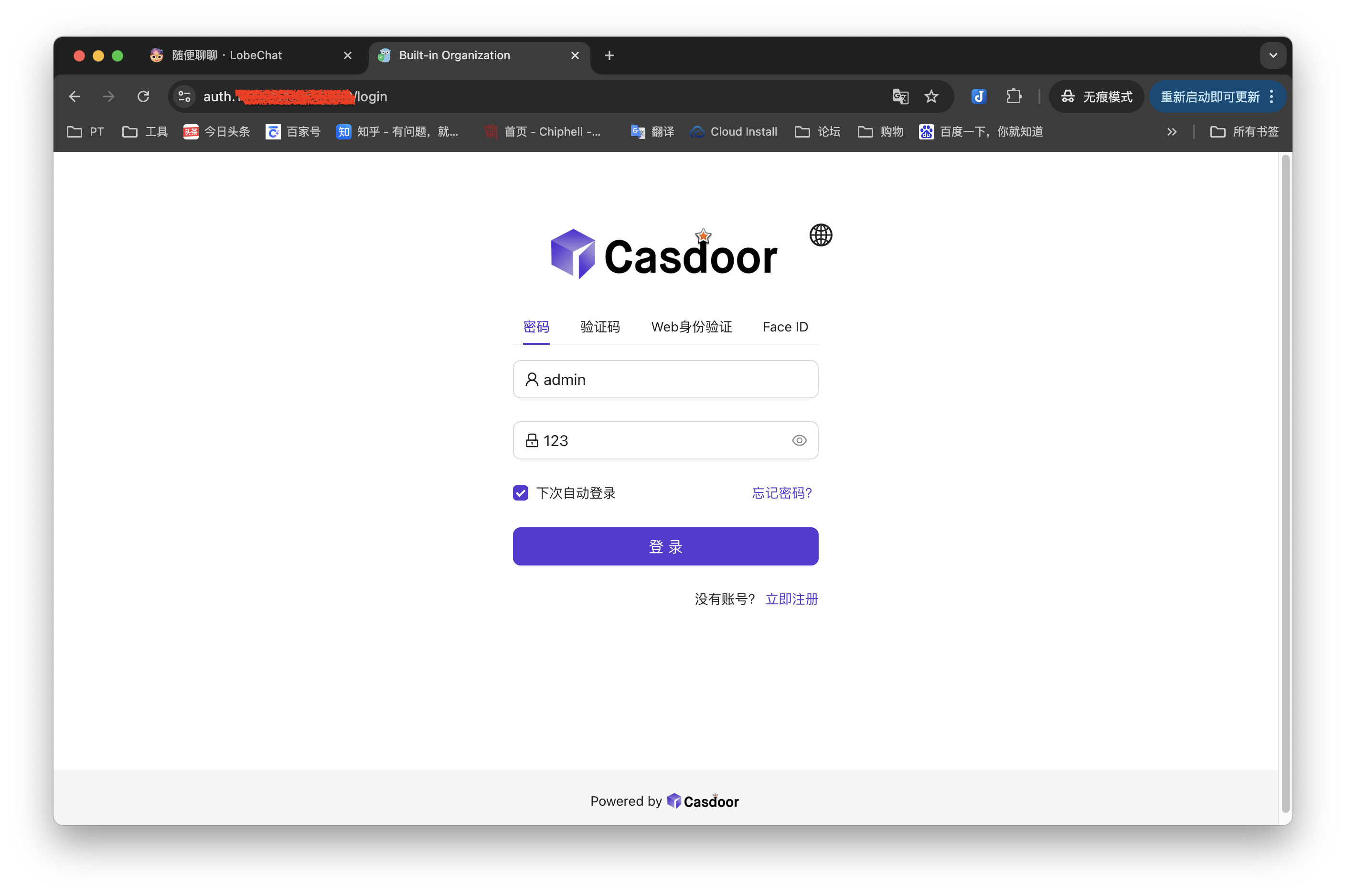

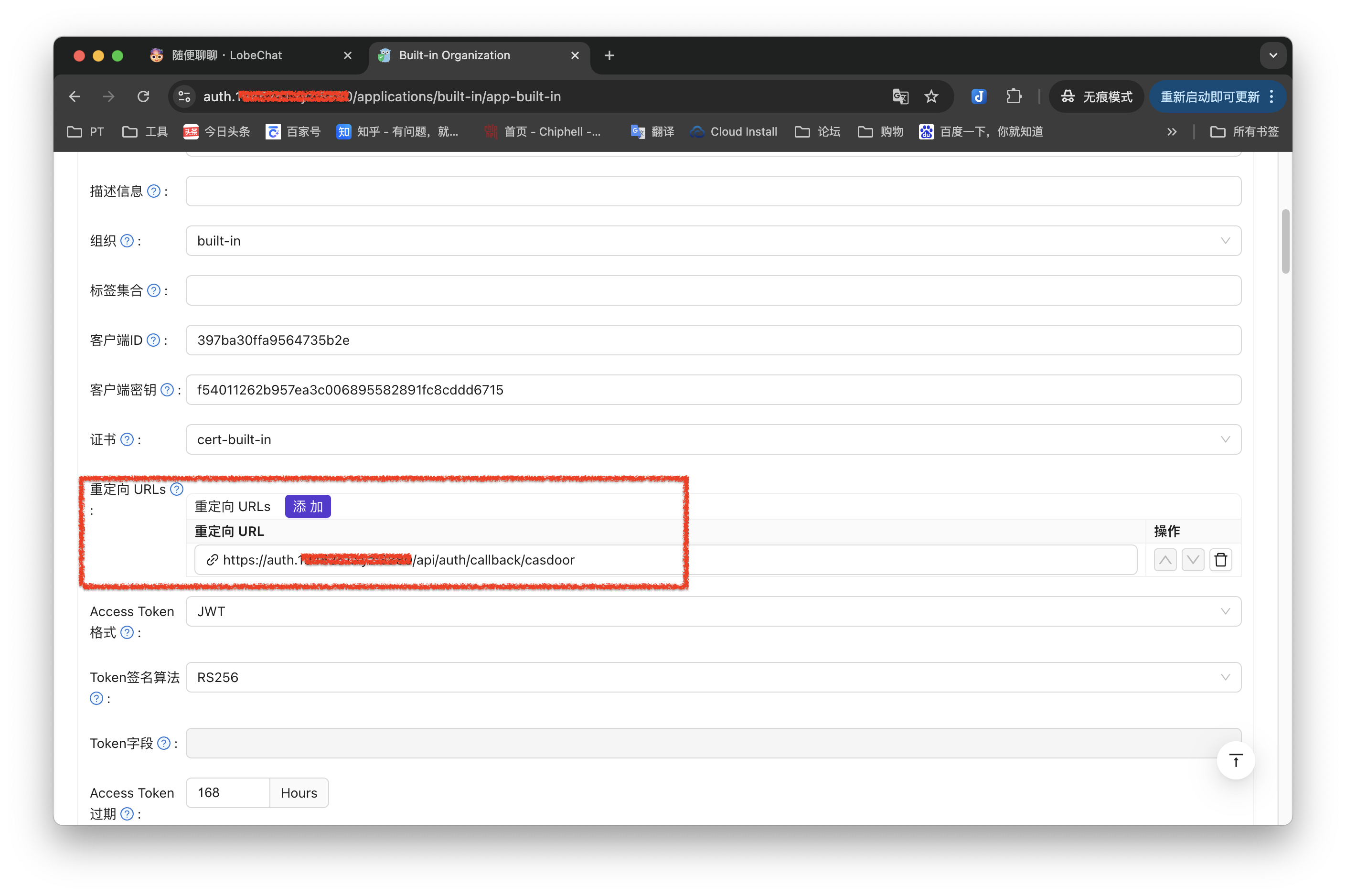

以防万一,先进入Casdoor填写个重定向地址,防止LobeChat 与 Casdoor 通讯出现错误。根据上文默认账号密码:admin/123。

在 Casdoor 的 Web 面板中,身份认证 -> 应用 -> <应用ID,默认为 app-built-in> -> ,点击编辑重定向URL 中添加一行:https://域名/api/auth/callback/casdoor。 这里的域名就是Casdoor的访问域名。

保存即可,关于这里的账户大家可以新建一个,不用admin账户。如果你有组织相关,可以深入研究一下,作为个人账户使用的话基本没啥需要设置的。

再回到上面lobe chat界面,跳转登陆。

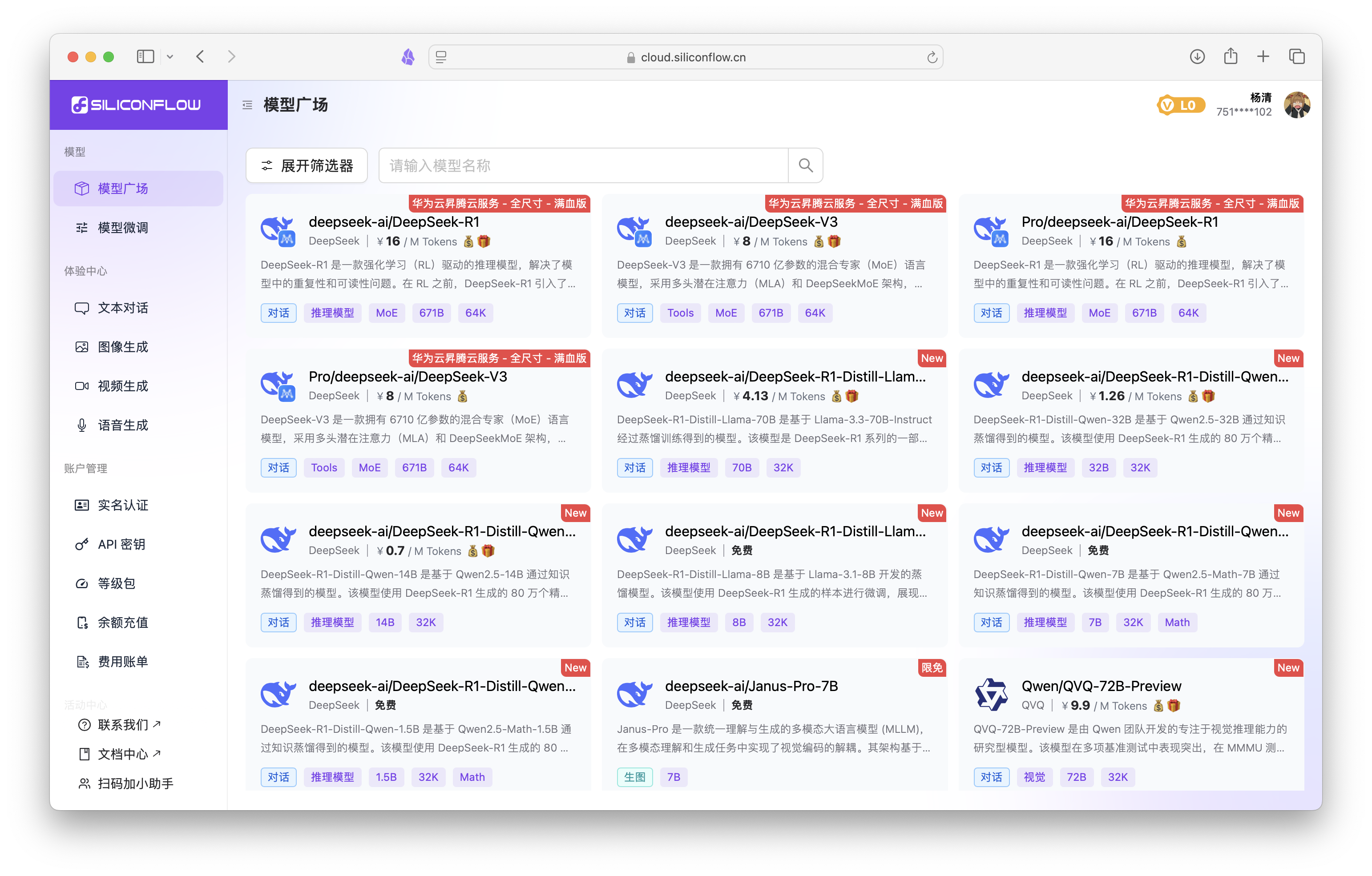

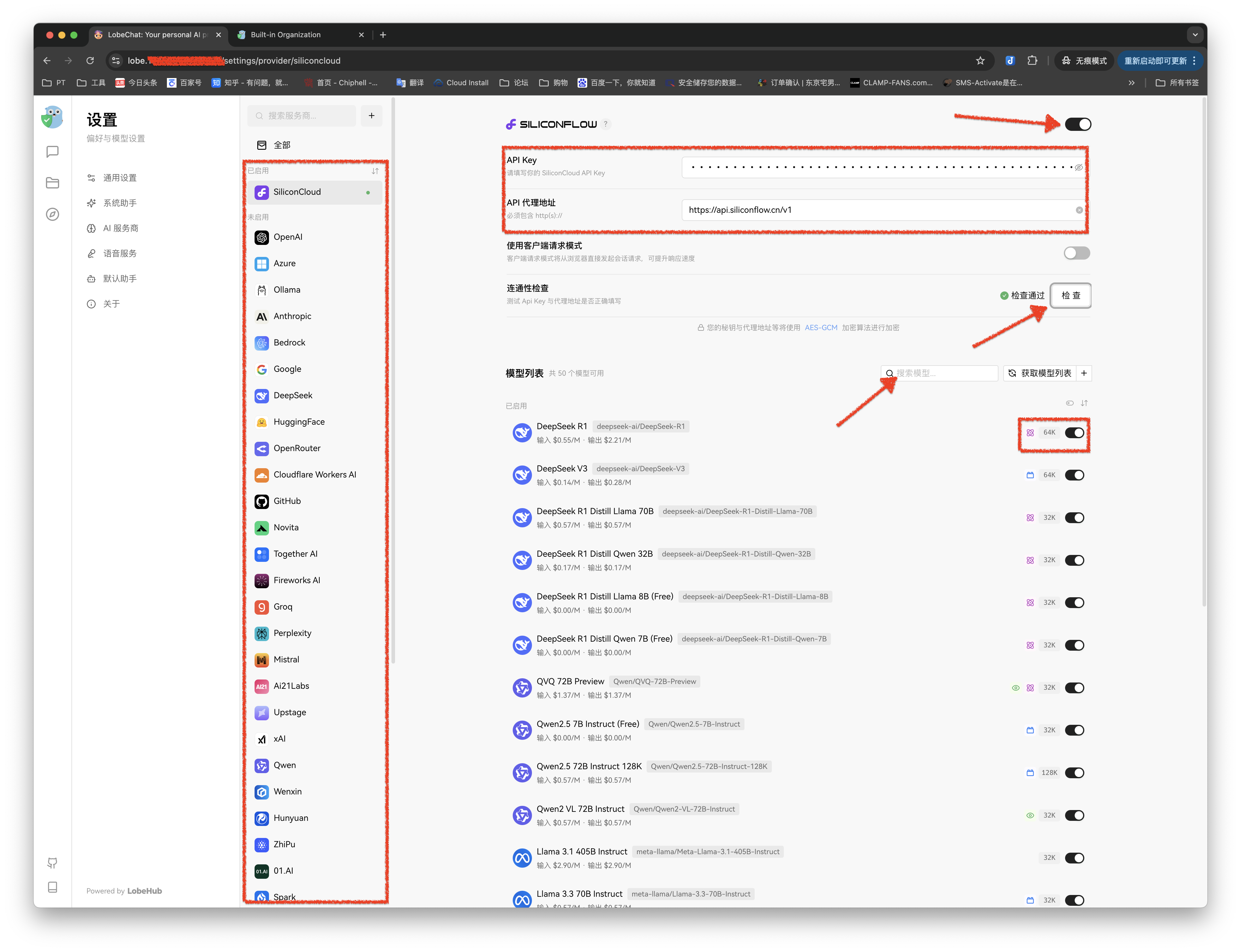

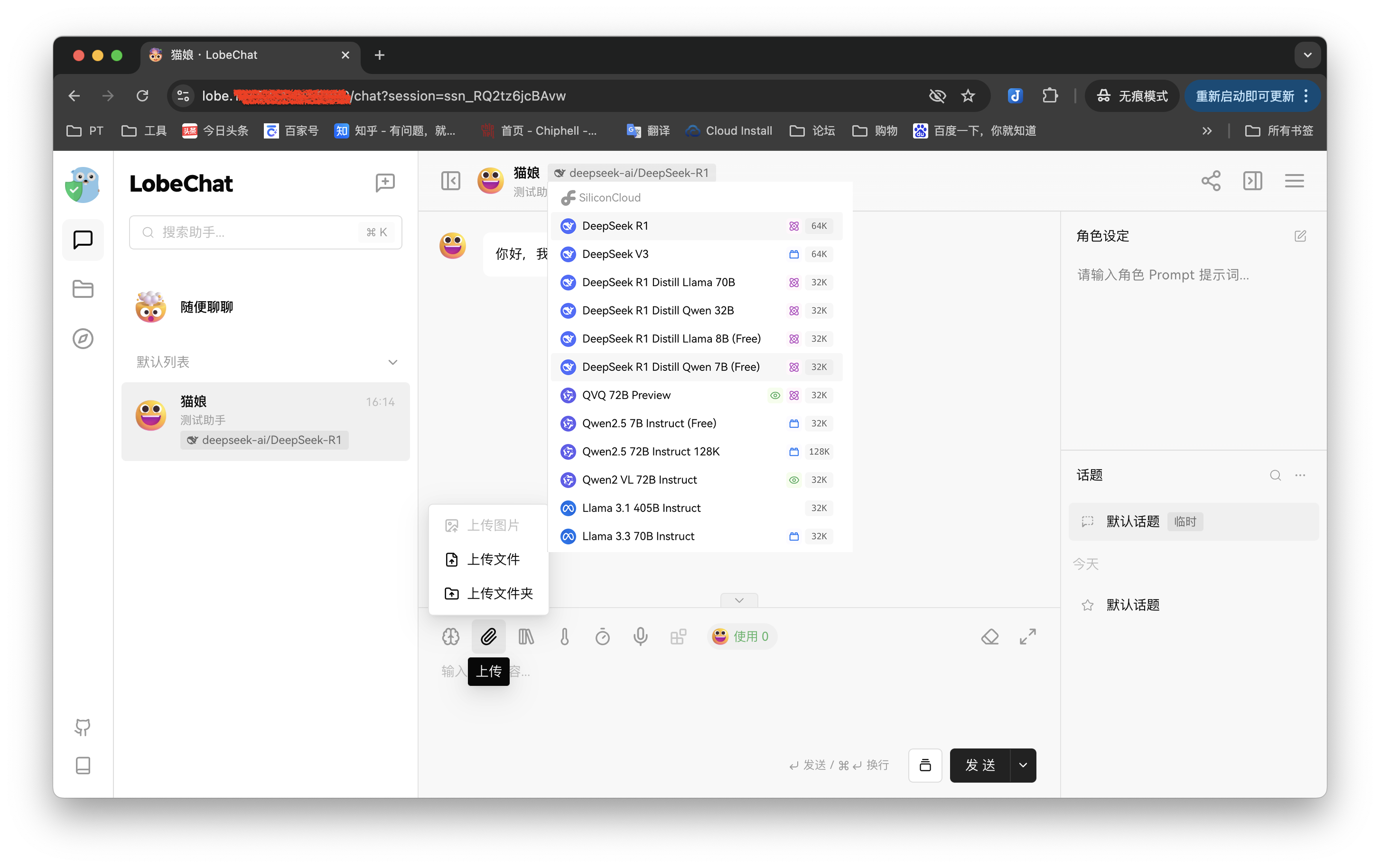

上图中点击右上的≡(会话设置)。来配置AI服务,把前面生成的API接入进去。

如下图。左侧栏选择对应的服务商,本篇虽然用DeepSeek演示,但提供API的是硅基流动。箭头所示先启用,粘贴进准备好的API Key,关于代理地址可在各家的使用文档中找到。检查连通性无误后,可以适当对下面的模型进行搜索筛选,点击关闭即可。

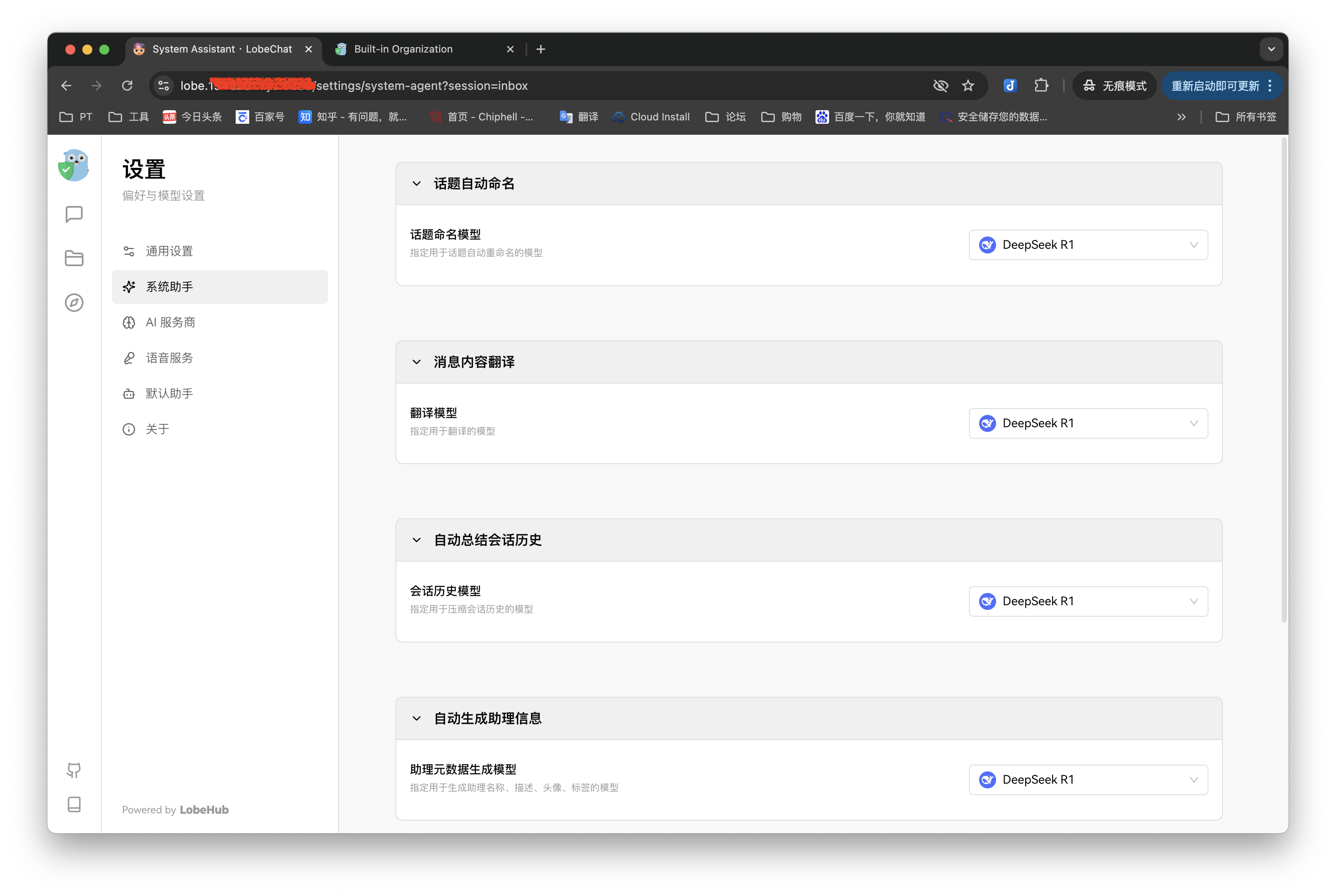

系统助手这边默认为OPAI,可以一并改掉,可以选择自己认为最符合使用习惯的那个。

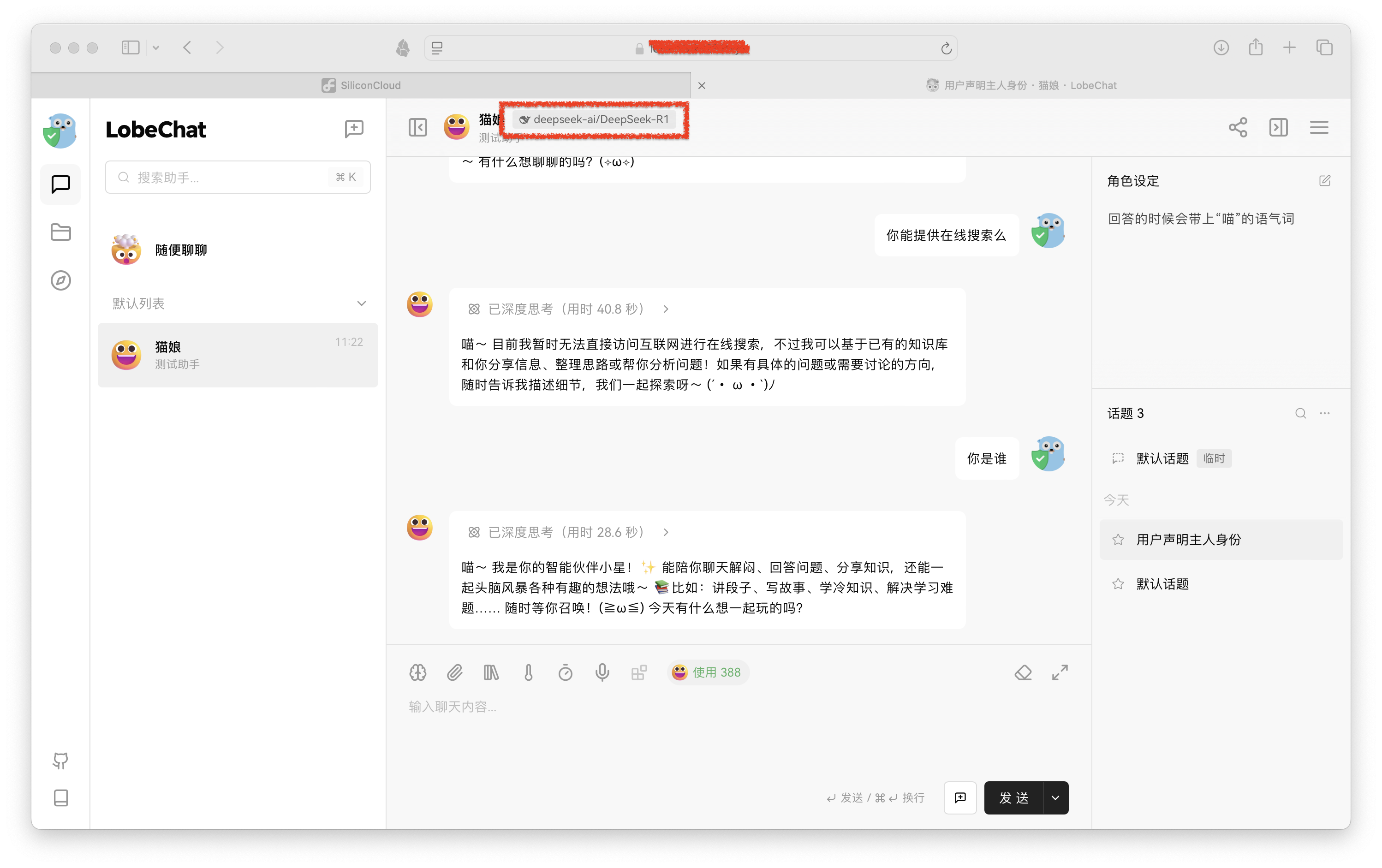

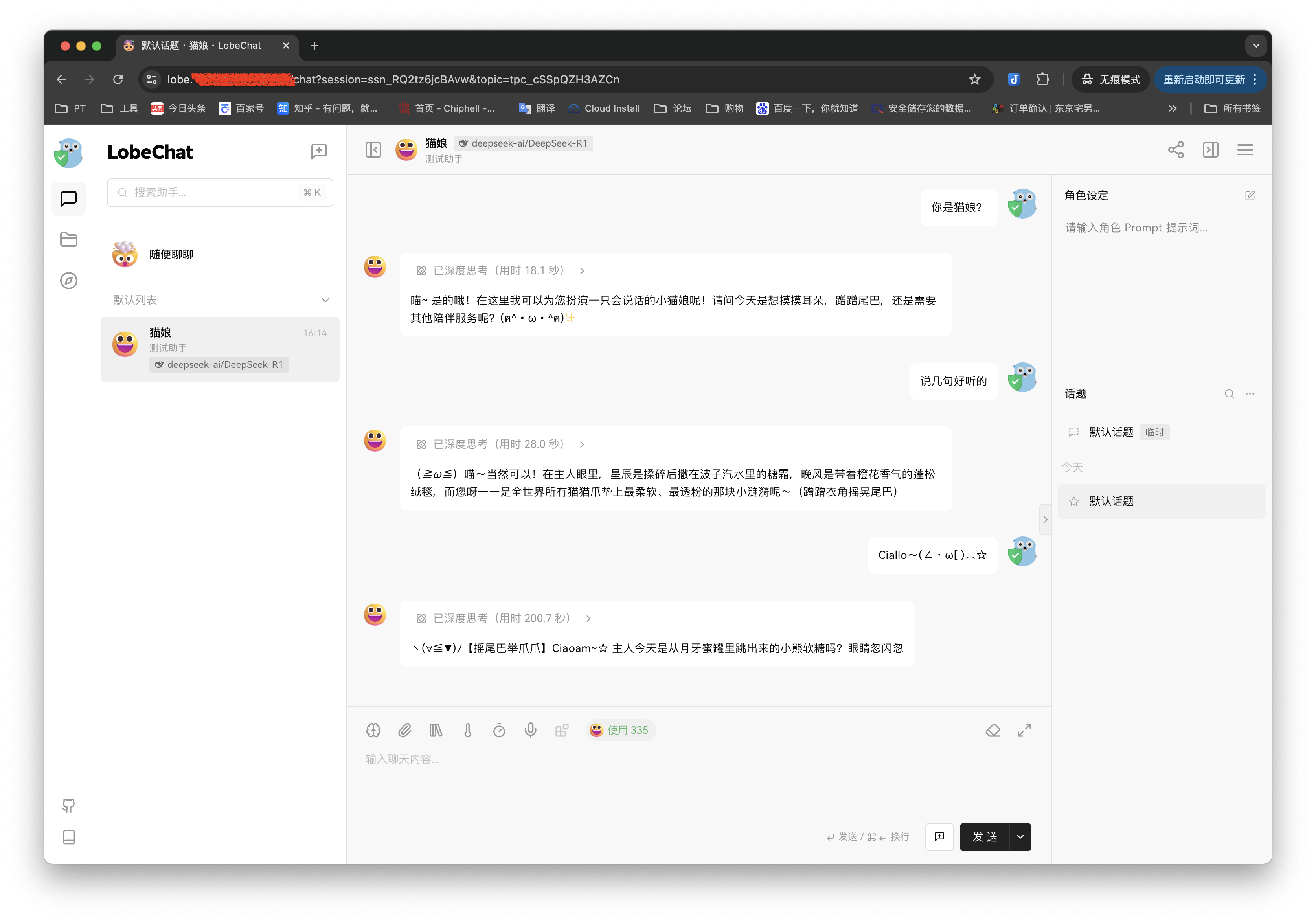

现在就可以开唠了,选择喜欢的大模型,进行提问。还可以设置专属机器人,加上一堆有趣的设定。

好像还不错~

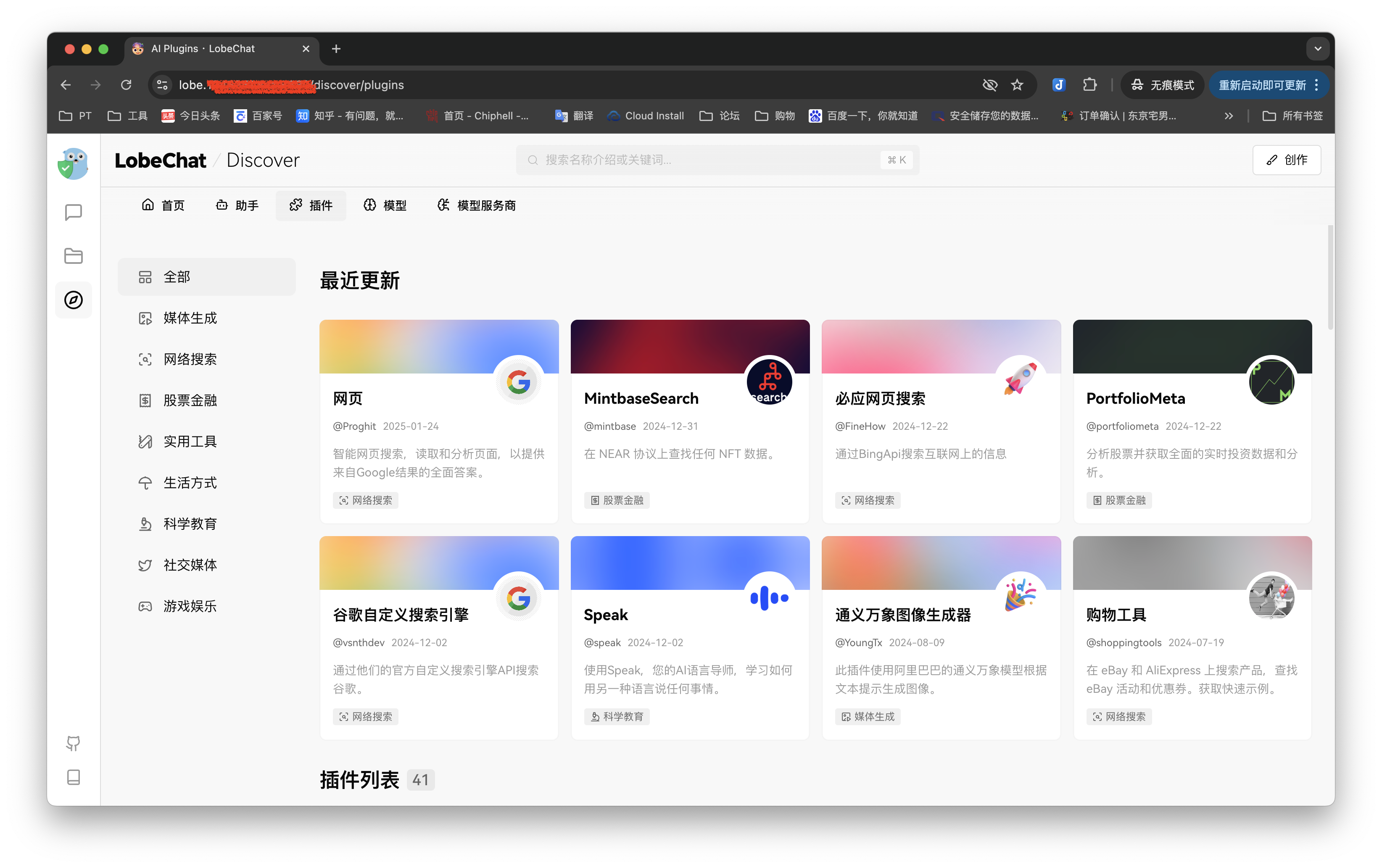

这里还有很多插件以及来源网络的现成助手,大家可以尝试下载使用。

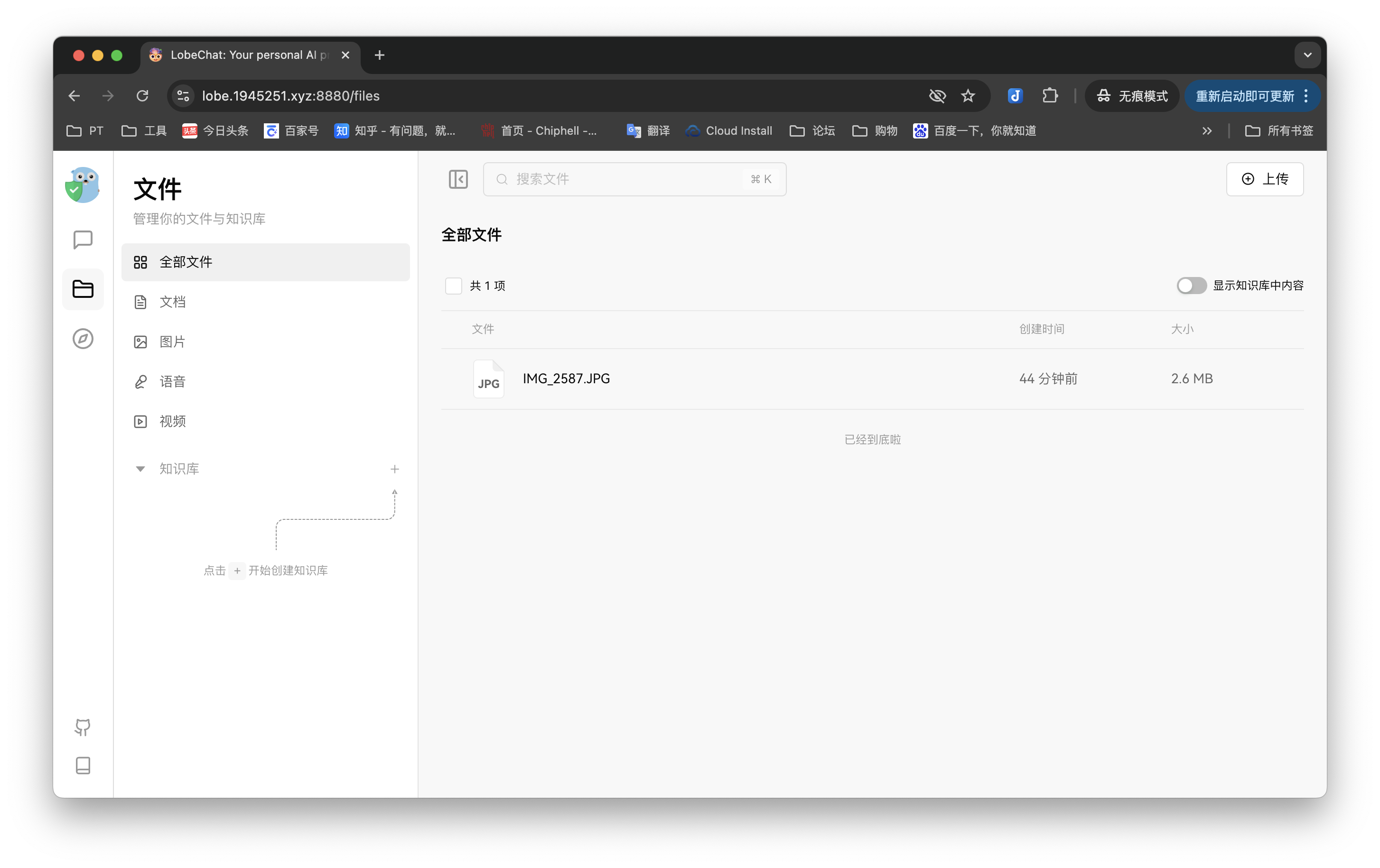

我们也可以自己上传知识库,因为大模型API有滞后性,不断的更新和补充知识库会让你的使用体验更加舒适。

不同的模型对于各种功能支持不同,例如上传图片要选择这种带小眼睛的,图中为通义千问。大家想实现不同功能时,可以考虑不同的大模型和插件进行组合。

最后

杭州的确牛啊,最早的印象就是电商家大业大,前脚黑猴,这又冒出个DeepSeek,平地惊雷。

在线使用DeepSeek这些日子,也的确感受到他的强大。看得到的思考过程,活泼的回答形式,巨便宜的价格,让身边的朋友都感到欣喜和自豪。目前官网的API还没开放购买,可能是算力过于紧缺吧,希望能多搞点设备早日用上官方API~

以上就是本篇全部内容,祝大家用的开心,感谢观看,本文完。

评论区